Что такое SEO аудит сайта

Существуют 4 переменные, которые влияют на то, как много вы будете получать трафика и продаж с Google.

- Целевая аудитория. Как много запросов и как часто вводят ваши потенциальные клиенты, какие задачи они намерены решить, какой их самый частый сценарий покупки (всегда ли они покупают после перехода с Google или предпочитают покупать в социальных сетях).

- Google. По какой формуле алгоритм Google в конкретный момент времени работает, как сканирует, индексирует и ранжирует сайты, за какие действия наказывает и поощряет.

- Ваши конкуренты. Насколько давно существует их сайт и как сильно он уже прокаченный ссылками, трафиком с других сайтов, насколько хороша их команда, стратегия и ресурсы, подключают ли они другие источники трафика (например брендовую оффлайн- и онлайн-рекламу), чтобы улучшить позиции в поиске.

- Вы сами. Насколько лучше ваших конкурентов вы знаете как работает Google и потребности своей целевой аудитории, как давно существует ваш сайт, насколько хороша ваша команда, стратегия и ресурсы.

Этот пошаговый чек-лист поможет вам проанализировать и улучшить ваш сайт. Но помните, что этого часто недостаточно, чтобы стать первым в нише. Кроме улучшения сайта, изучайте свою целевую аудиторию, конкурентов и следите за обновлениями Google.

Запустите SEO аудит сайта

Пока вы будете изучать чек-лист, Sitechecker сделает онлайн аудит вашего сайта и сформирует список задач по исправлению ошибок

Когда нужен SEO аудит

1. Перед запуском сайта

Именно в момент создания сайта вы задаете его структуру, адреса страниц, ссылки, мета-теги и другие важные элементы. Аудит сайта перед его публикацией поможет вам избежать ошибок, которые могут затормозить рост его видимости в поиске.

2. Перед покупкой и продажей сайта

Если вы продаете сайт, то вам важно привести его в товарный вид 🙂 Если покупаете, то вам важно оценить все его уязвимости и ошибки, которые могут привести к проблемам в будущем. Чем выше стоимость сделки, тем целесообразнее тратить время на тщательный аудит.

3. Перед и после миграции сайта

Миграция сайта – это процесс еще более сложный, чем запуск. Это один из самых опасных процессов, после которого сайт легко может потерять позиции из-за технических ошибок. Нужно провести аудит сразу двух версий сайта, старой и новой. При этом нужно проверить, чтобы перенос ссылочного веса, контента произошел правильно. Используйте наш чек-лист по переезду сайта, чтобы избежать самых частых ошибок во время миграции.

4. После внесения больших изменений на сайт

Большими можно назвать изменения, которые затрагивают больше 20% страниц или касаются самых ценных страниц по трафику и конверсиям. Примеры таких изменений: изменение URL-адресов, изменение дизайна сайта, добавление новых скриптов и стилей, изменение внутренней перелинковки, удаление и добавление страниц, добавление новых языковых версий сайта.

Все эти ситуации содержат риски, что беглым взглядом вы не увидите тех проблем с которыми столкнутся бот Google и пользователи при посещении новой версии сайта.

5. Для регулярного поиска проблем

Даже если вы работаете с сайтом медленно, периодически внося небольшие правки, спустя время количество проблем может накопится и затормозить ваш рост. Чаще всего накапливаются проблемы связанные с битыми ссылками, редиректами, появлением дубликатов и малоценных страниц, каннибализацией запросов.

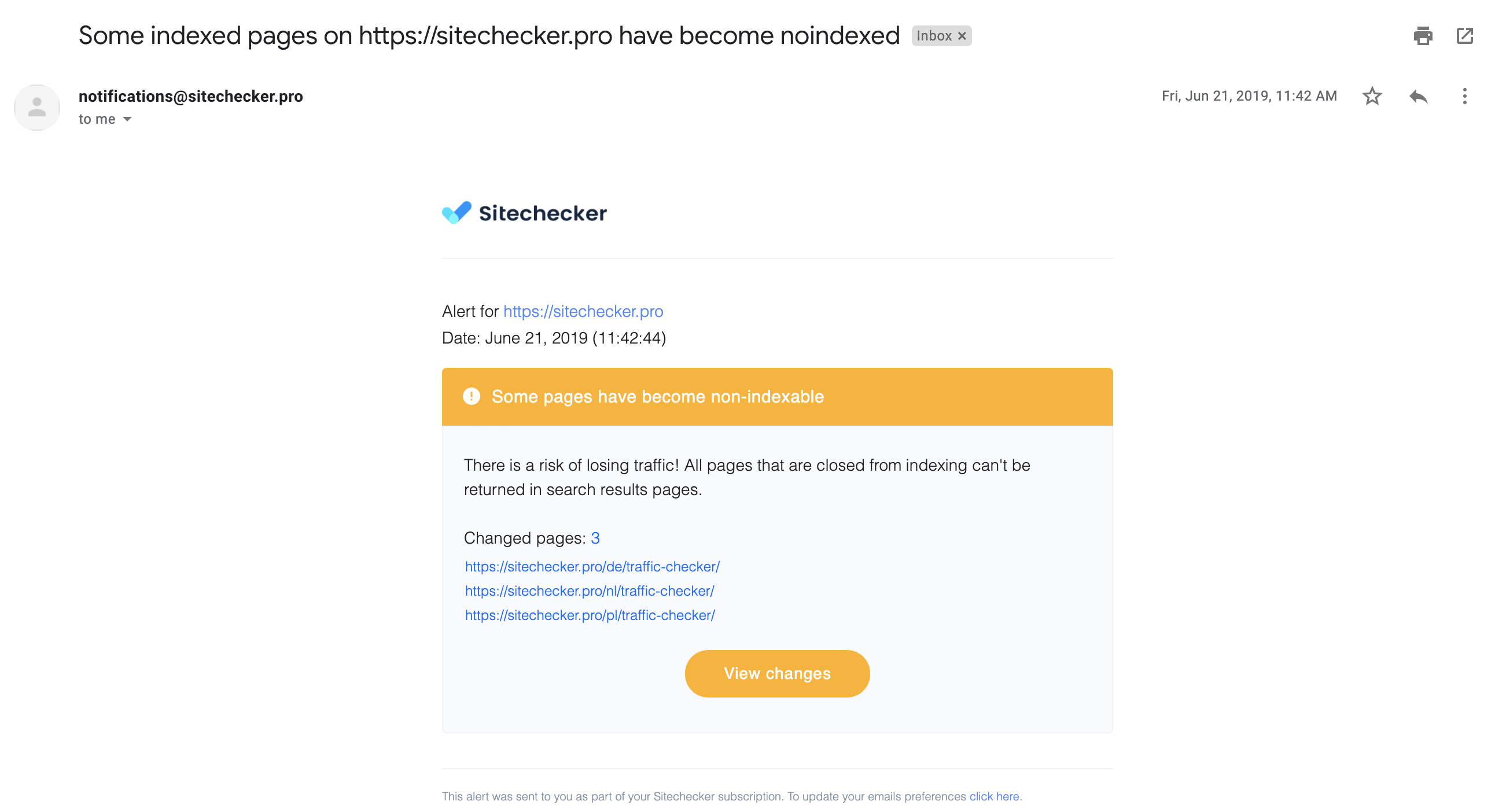

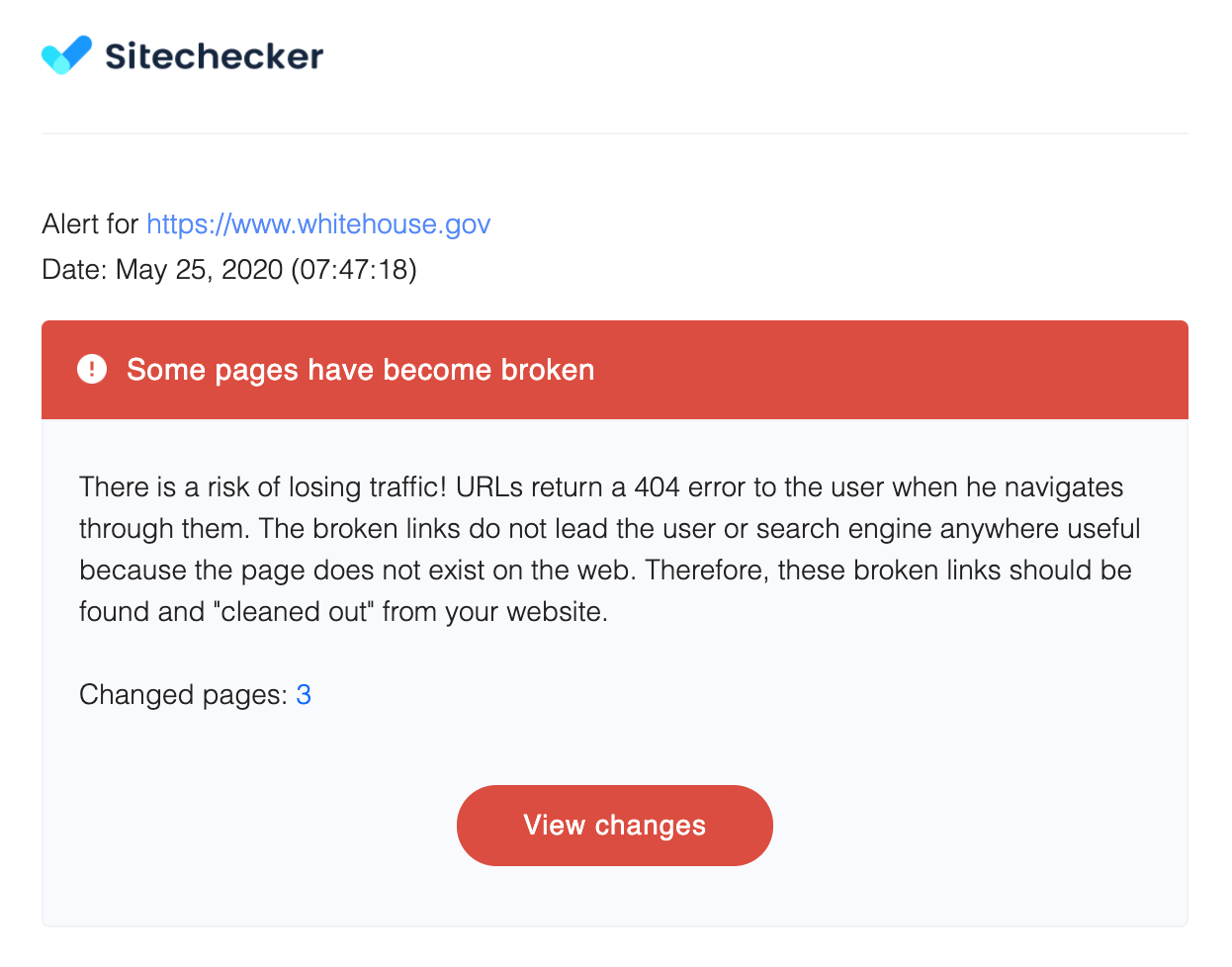

Поэтому важно поставить себе за правило проводить аудит раз в месяц, квартал, полгода, год, в зависимости от вашей динамики работы над сайтом. Но ручной вариант все чаще уходит в прошлое. Некоторые инструменты могут сканировать ваш сайт раз в месяц, неделю, день и отправлять вам уведомления, когда находят технические ошибки на сайте.

Вот пример письма, которое шлет Sitechecker, при нахождении страниц, которых закрыли от индекса.

6. Для создания или корректировки стратегии продвижения

На этом этапе SEO аудит проходит с использованием данных Google Analytics и Google Search Console. Нам нужны данные по эффективности страниц, ключевых слов, обратных ссылок, чтобы выявить, где мы можем быстрее всего получить прирост трафика и конверсий, какие страницы нам нужно поставить в приоритет, а какие наоборот, уделить или объединить.

19 самых важных шагов SEO аудита сайта

Попробуйте пройти все 19 шагов самостоятельно. Я привел ниже инструкции, цитаты и инструменты, которые помогут провести аудит сайта быстро и просто. Кроме текстовой версии есть еще и видео чек-лист, где вы можете увидеть на реальных примерах, как проходит процесс аудита.

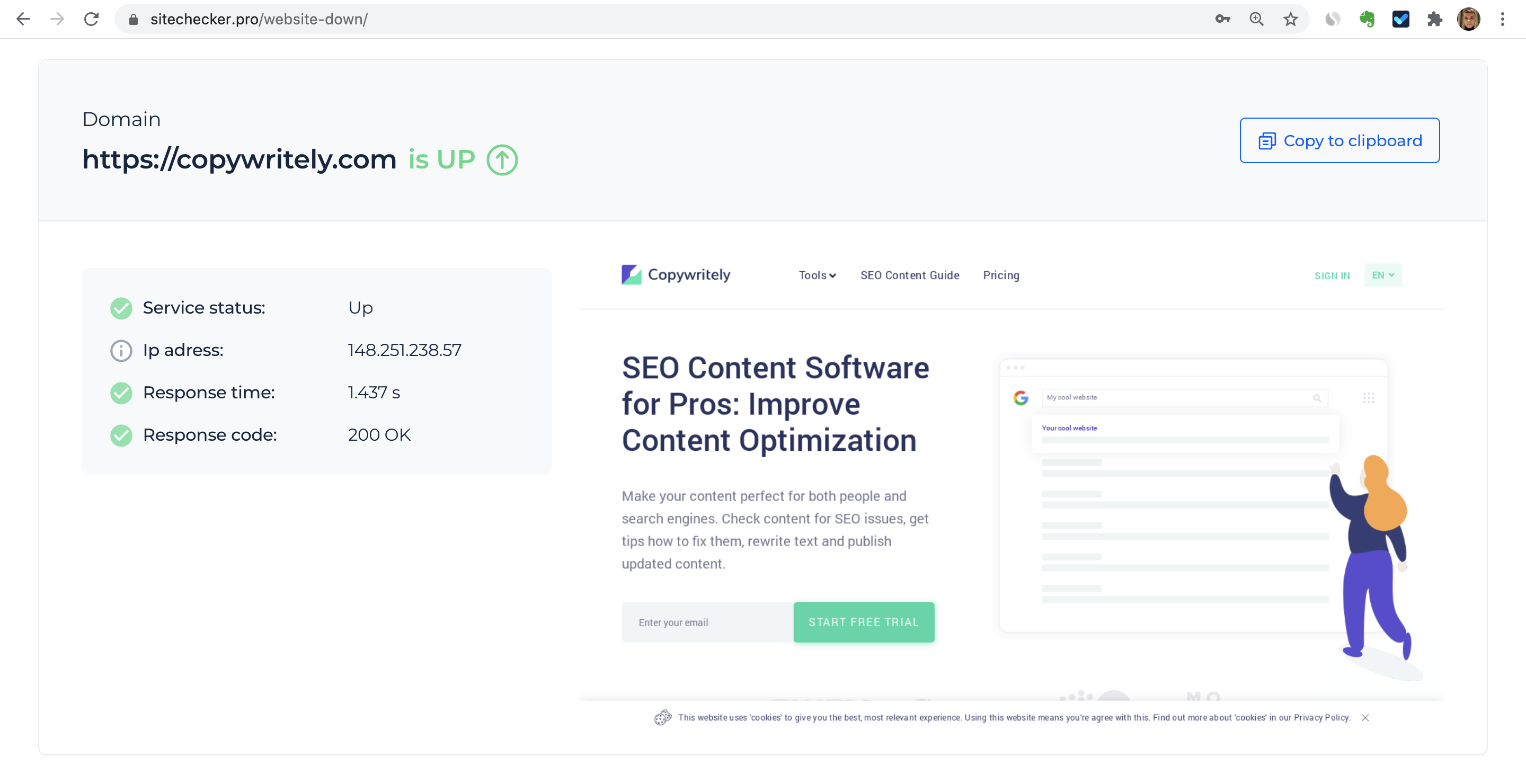

1. Проверьте работает ли сайт

Для этого просто перейдите на сайт с любого устройства и удостоверьтесь, что сайт загружается. После этого, проверьте доступность сайта глазами робота.

Если важно проверить доступность сайта в разных странах, можете попробовать инструмент от Uptrends.

Сайт может не загружаться по самым разным причинам: просроченный домен, ошибки при обновлении плагинов или CMS, авария или технические неполадки на стороне хостинг-провайдера, DDoS атака или взлом сайта хакерами.

Сложно подготовится к каждой из этих проблем, но можно снизить время неработоспособности сайта за счет быстрой реакции на проблему. Настройте автоматический мониторинг сайта на доступность, при этом лучше всего сразу в нескольких инструментах.

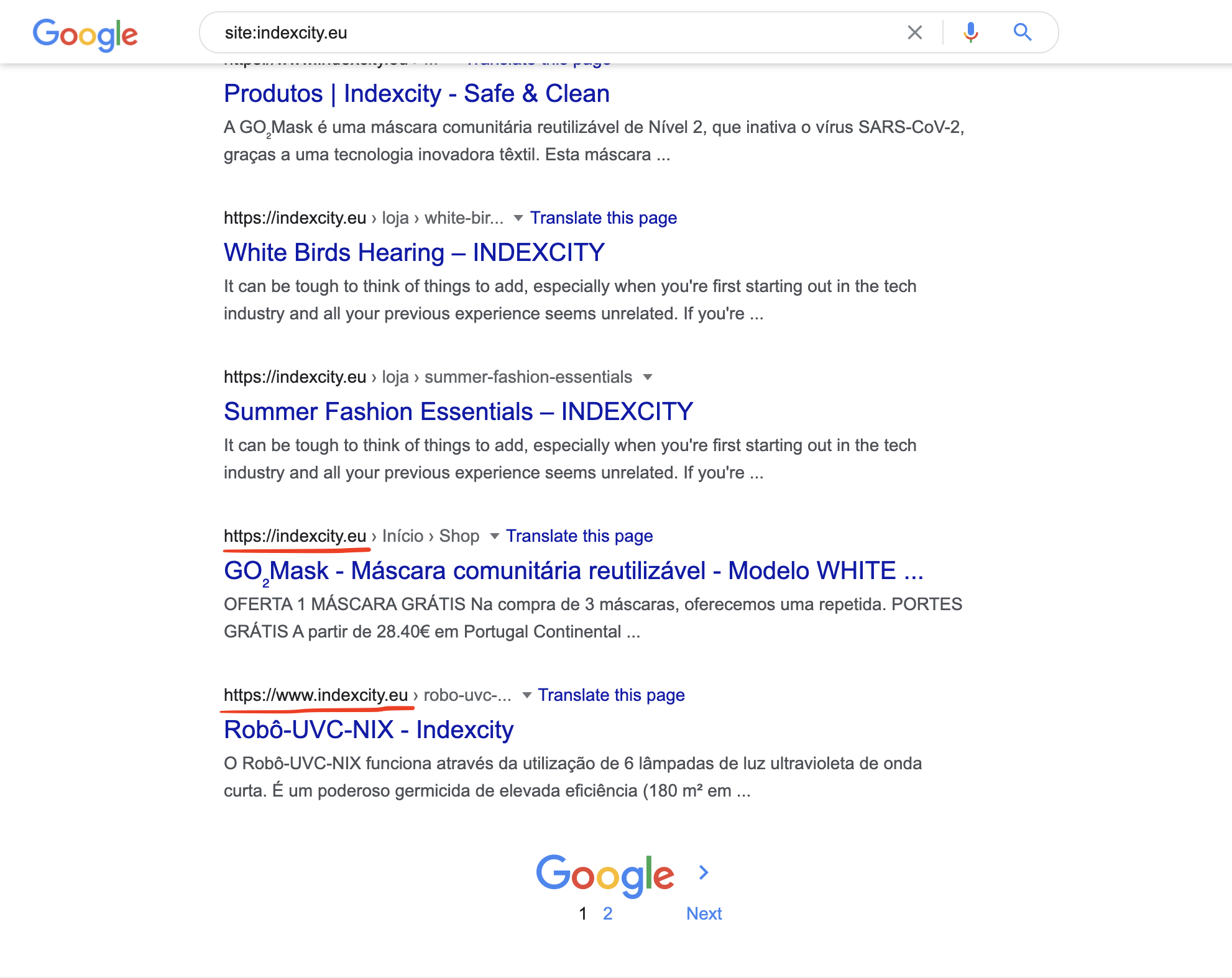

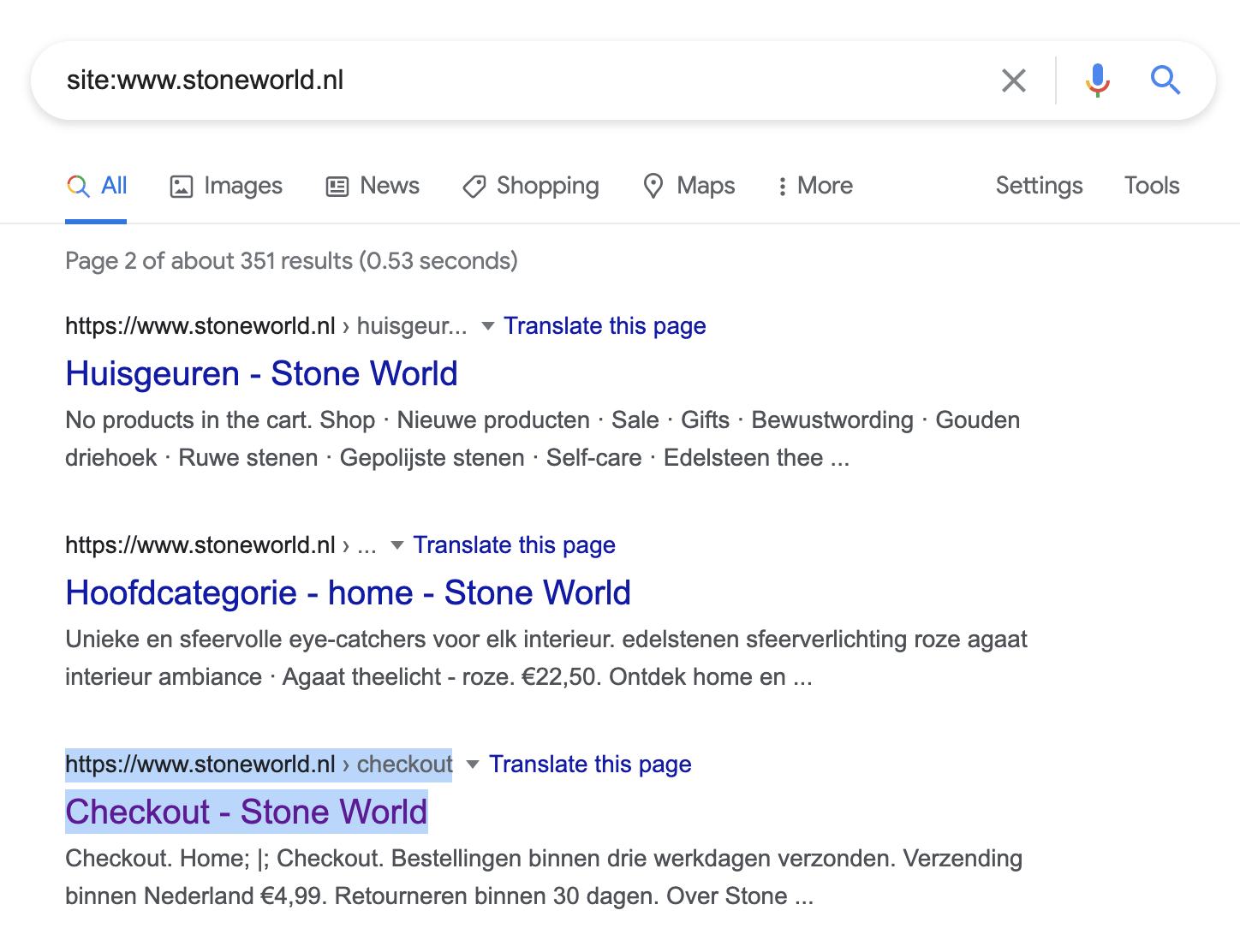

2. Проверьте есть ли сайт в выдаче

На этом этапе мы пока смотрим только наличие сайта на странице результатов поиска, без оценки каких-либо ошибок. Вбейте запрос site:domain.com в поиске Google. Этот метод мы будем далее использовать часто для поиска разных проблем.

Сайт может отсутствовать в поиске по самым разным причинам.

- Сайт слишком новый и Google о нем еще не узнал;

- На сайте отсутствует или мало контента;

- Вы закрыли сайт от индексирования и / или сканирования поисковым ботом;

- Сайт попал под фильтр или штрафные санкции.

Если вы столкнулись с этой проблемой, то нужно провести отдельный аудит причины отсутствия сайта в выдаче. И после того, как исправите это, можно переходить к следующим шагам.

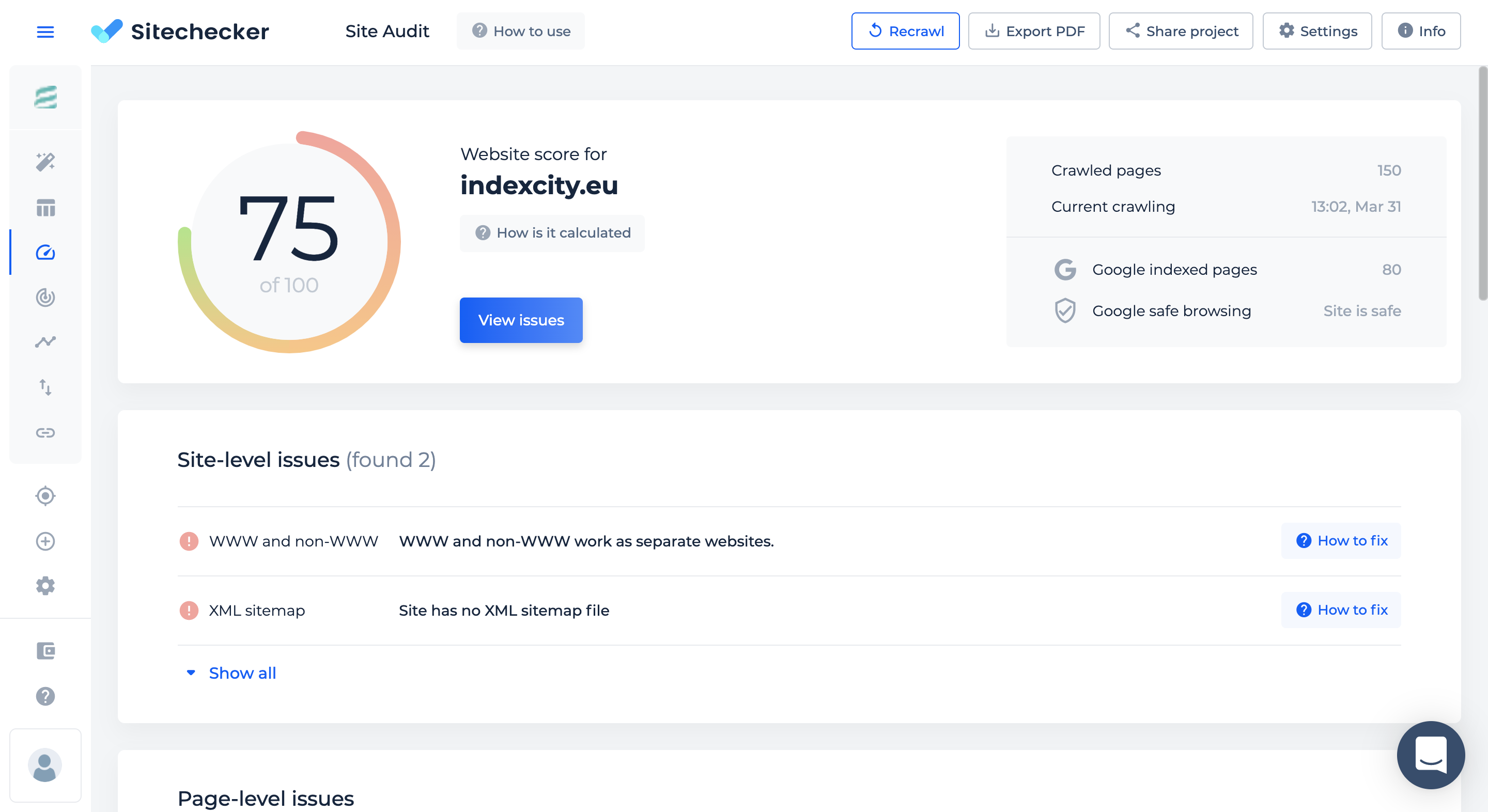

3. У сайта только одна рабочая версия

Если у сайта несколько рабочих версий (то есть имеют статус код 200), то это может привести к появлению дублей в Google, индексированию страниц на разных версиях домена, распылению ссылочного веса между нескольких версиями домена.

Из четырех версий домена:

- http://domain.com

- https://domain.com

- http://www.domain.com

- https://www.domain.com

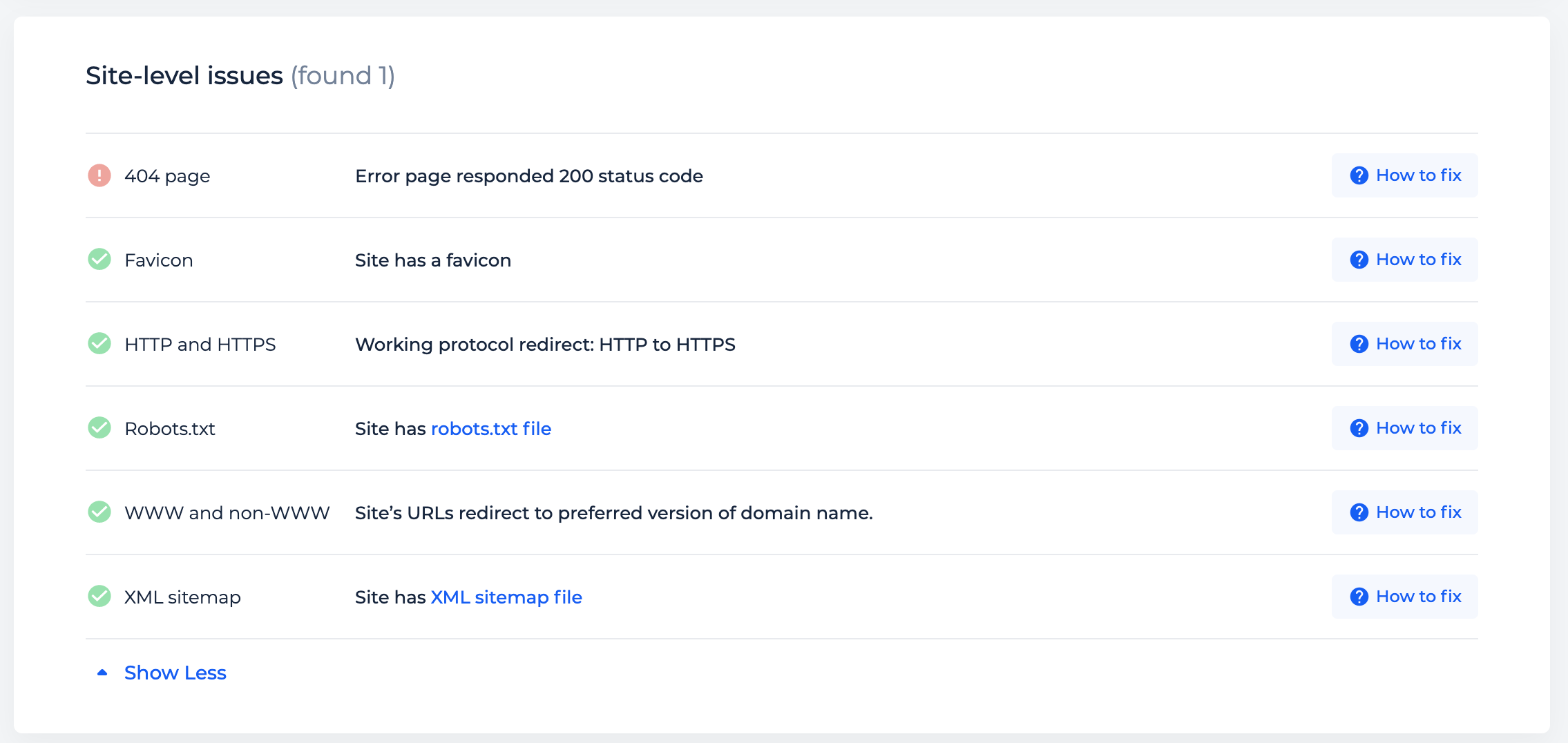

200 статус код должен быть только у одной версии, а три оставшиеся должны редиректить на основную. К дублям страниц могут приводить и другие ошибки, но проблемы с редиректами между HTTP и HTTPS, WWW и non-WWW касаются всего сайта. Sitechecker поможет выявить такие проблемы.

4. Сайт загружается с разных устройств

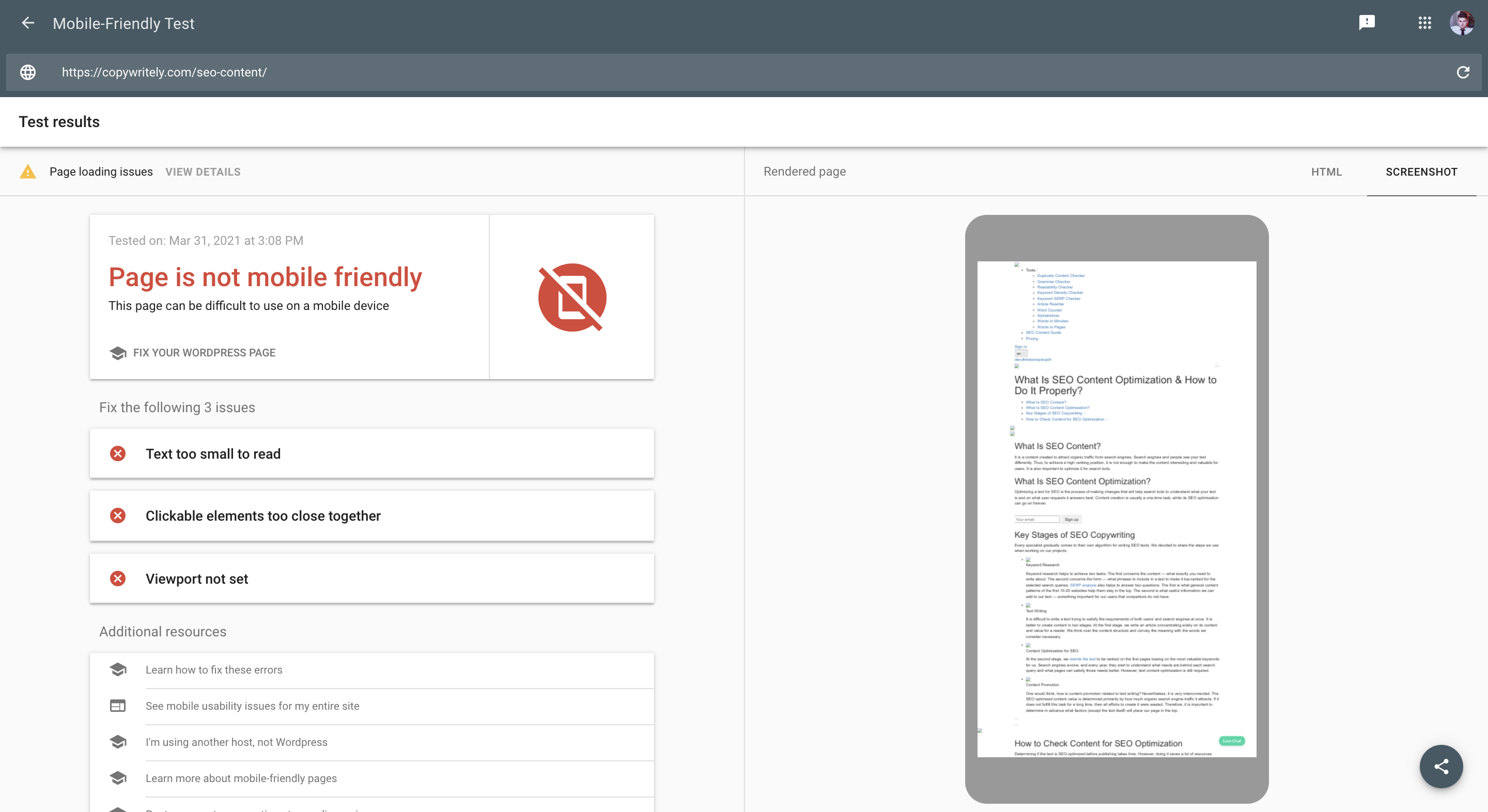

Для этого на сайт также нужно посмотреть своими глазами и глазами робота Google. Зайдите на сайт со своего мобильного и запустите проверку в инструменте Mobile-Friendly Test.

Например, с мобильного я вижу, что страница https://copywritely.com/seo-content/ грузиться отлично.

Но когда я провожу проверку в инструменте, то вижу, что страница не адаптирована для мобильных устройств.

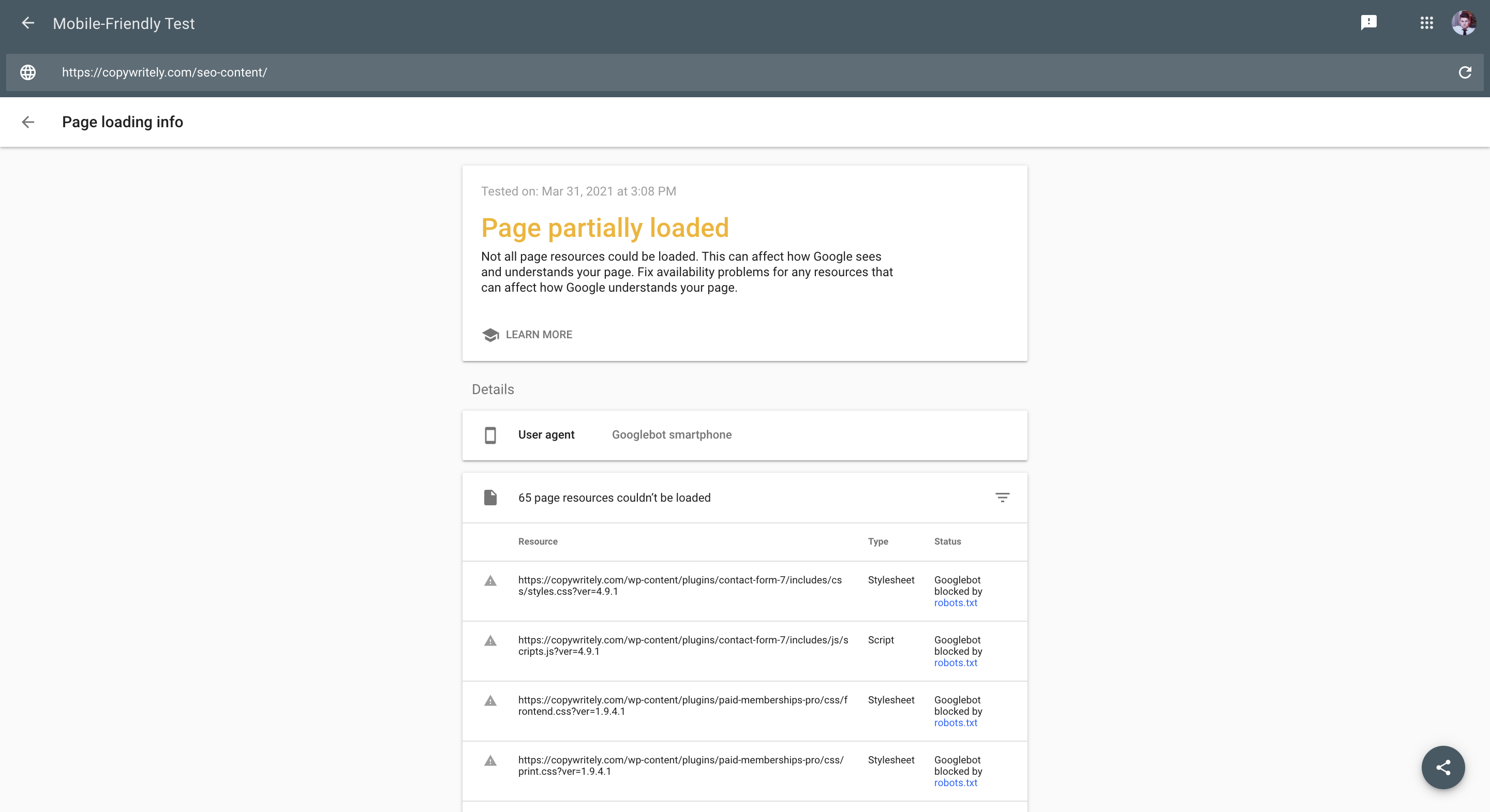

Если перейти к деталям отчета, то можно увидеть все проблемы, которые нашел инструмент. Часть картинок и CSS, JS файлы закрыты от сканирования в robots.txt. Потому робот Google не видит страницу так, как ее видит конечный пользователь.

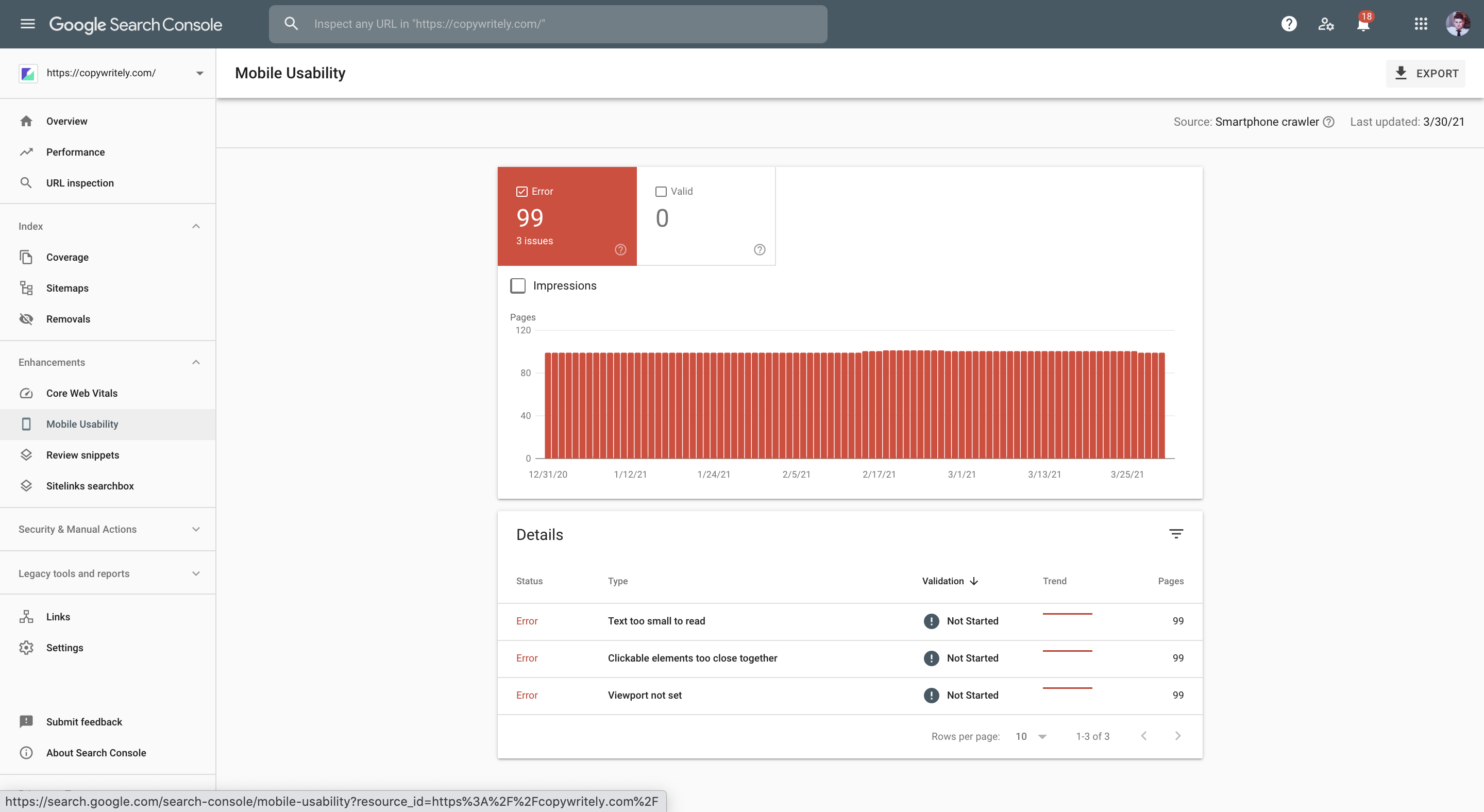

Если вы уже добавили сайт в Google Search Console, то можете увидеть сводку проблем по адаптивности всех страниц.

Важно также, что инструмент может показать вам ошибки, которые вы сами бы не заметили. Например то, что кликабельные элементы слишком близко друг к другу.

5. Сайт работает на HTTPS версии

Еще недавно внедрение HTTPS было только рекомендацией Google. Сейчас это практически обязательный пункт, даже для сайтов, которые не хранят информацию пользователей и на которых нет проведения транзакций.

Хотя однократное посещение одного из ваших незащищенных веб-сайтов может показаться безобидным, некоторые злоумышленники смотрят на совокупную активность ваших пользователей при просмотре, чтобы сделать выводы об их поведении и намерениях и расскрыть их личности.

Например, сотрудники могут непреднамеренно сообщать своим работодателям о проблемах со здоровьем, просто читая незащищенные медицинские статьи.<...>

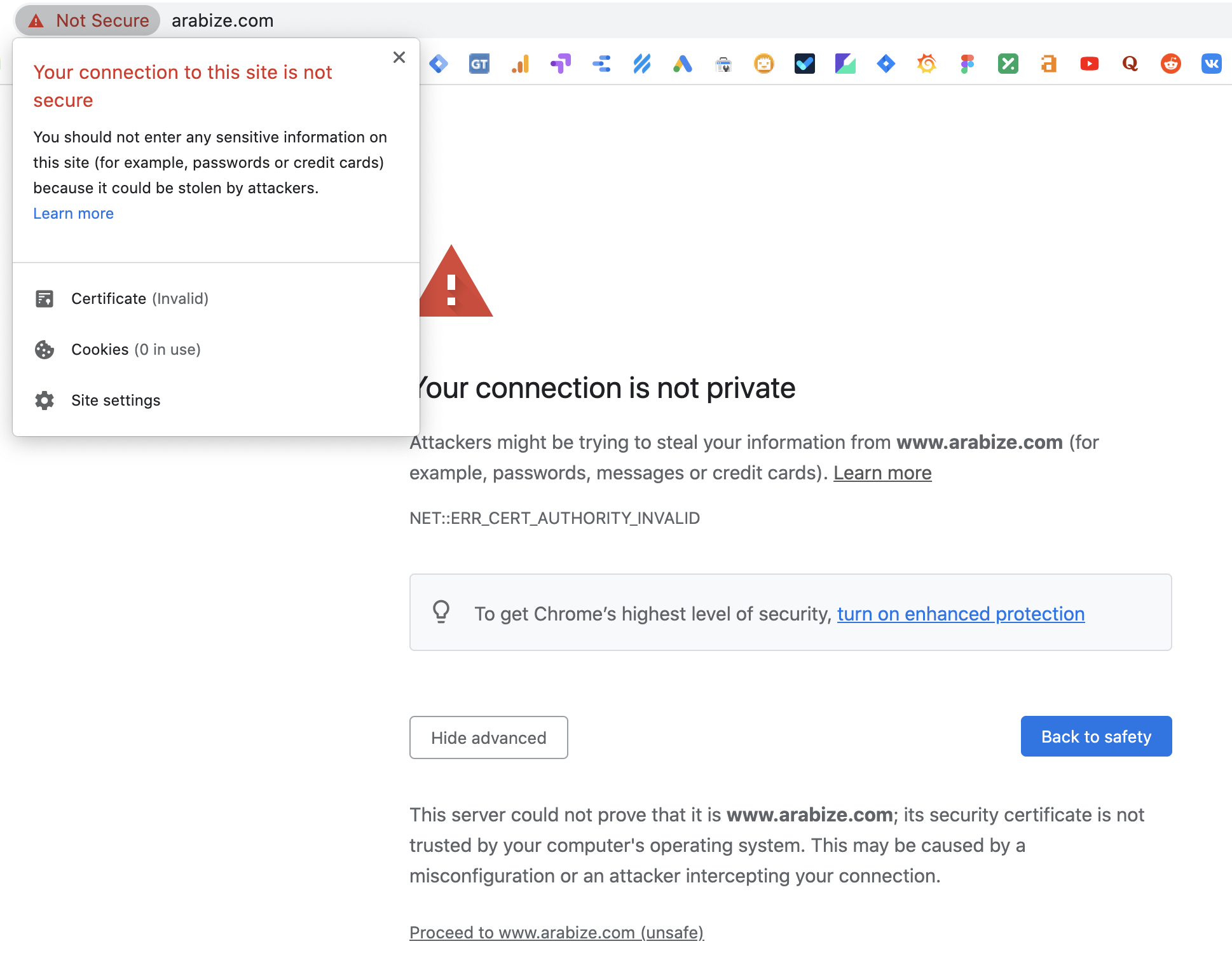

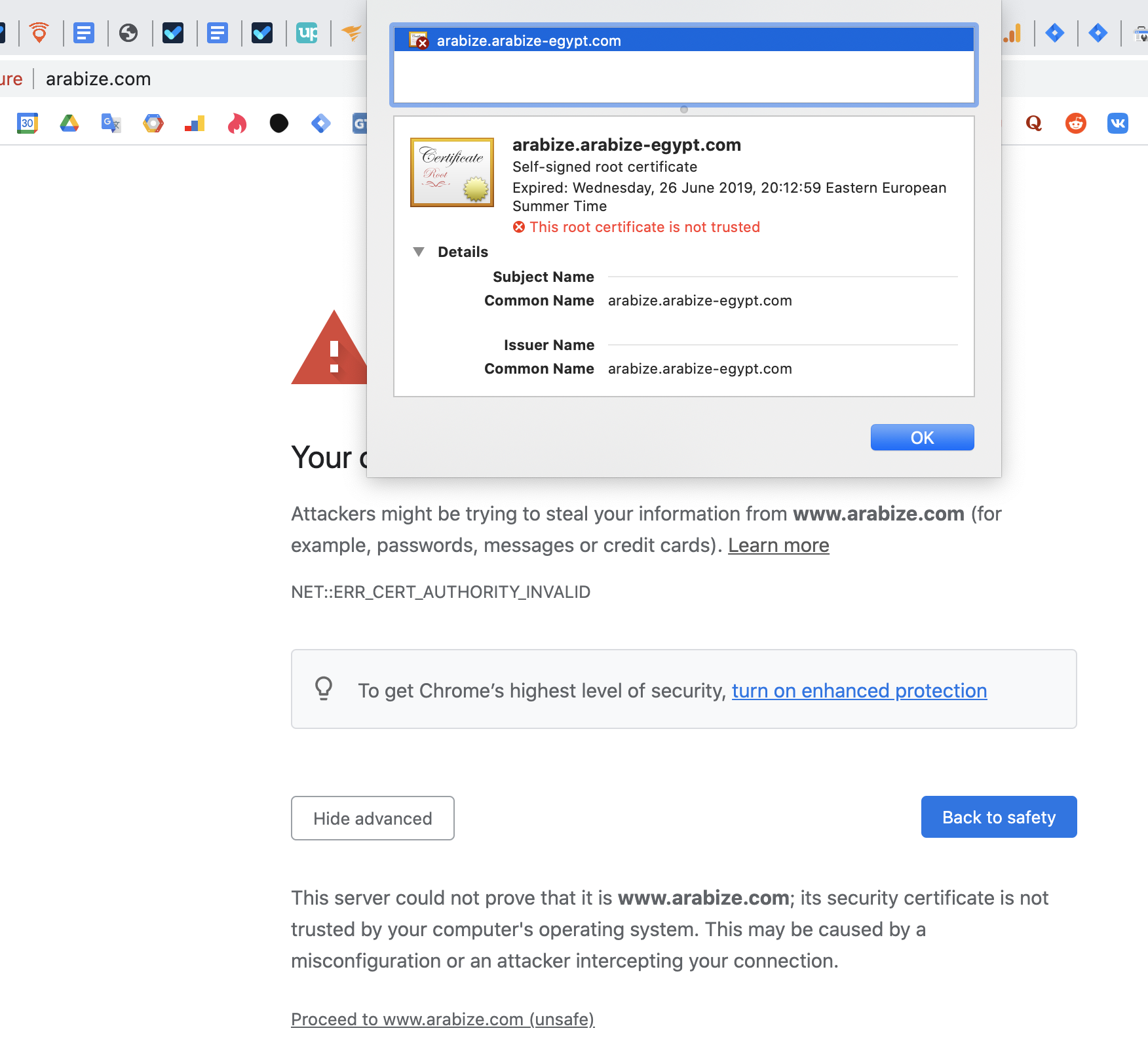

При этом важно не только, чтобы HTTPS сертификат присутствовал, но и чтобы он был валидным. Почти все браузеры (я проверил в Google Chrome, Opera, Safari) показывают уведомление о проблемах с сертификатом. Как правило на сайт все еще можно попасть, но еще через спустя два клика.

Если пользователи попадают на ваш сайт впервые, то вряд ли они захотят перейти на ресурс после такого уведомления браузера.

Причину невалидности сертификата можно также легко узнать. Нужно кликнуть на сообщение Not secure в строке браузера и перейти на детали SSL сертификата.

Я у себя на всех сайтах использую сертификат Let’s Encrypt. Многие хостинги уже вшивают автоматический выпуск и продление этих сертификатов, как услугу по умолчанию. Поспрашивайте своего хостера об этом.

6. Сайт безопасен для пользователей

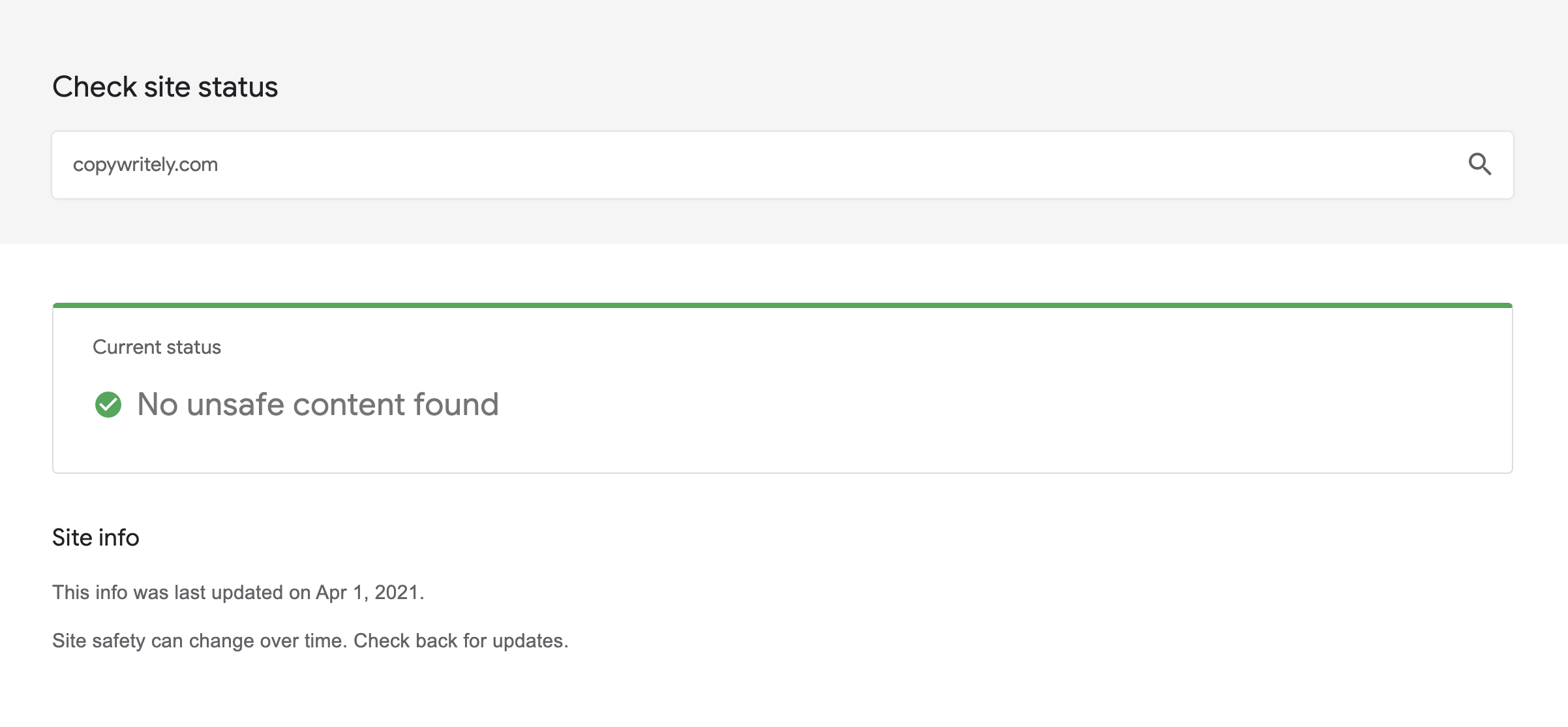

Наличие HTTPS добавляет вашему сайту доверия в глазах пользователей, но не страхует полностью от каких-либо уязвимостей. На протяжении длительного времени на сайте может быть установлено вредоносное или нежелательное програмнное обеспечение (ПО) или контент, который использует методы социальной инженерии для манипуляции вашими пользователями, и вы об этом не будете знать.

Для быстрого уведомления владельцев сайтов о таких проблемах Google создал специальный отчет в Google Search Console “Проблемы с безопасностью”. Также для самостоятельной проверки любого сайта можно использовать Google Transparency Report.

Я сам сталкивался с такой проблемой. На моем сайте показывались рекламные баннеры при посещении его с мобильного устройства. Если вы используете WordPress, то такое может происходить в том числе из-за взлома плагинов или тем, которые у вас установлены. Используйте справку Google, чтобы узнать детальнее как защитить свой сайт.

7. Сайт отсутствует в черных списках email-рассылок

Черный список – это список доменов, IP-адресов и email-адресов, на которые пользователи жалуются за рассылку спама. Они бывают публичными и частными. Люди могут использовать эти списки, чтобы блокировать нежелательные рассылки.

Если вы отправляете письма своим клиентам, то легко можете попасть в них и затормозить эффективность своего email-маркетинга. Если же вы шлете пользователям еще и продуктовые письма, то репутация вашего домена становится критически важна.

Примеры известных черных списков:

- Spamhaus Block List (SBL);

- Composite Blockinng List (CBL);

- Passive Spam Block List (PSBL);

- Spamcop;

- Barracuda Reputation Block List (BRBL).

На каждом из этих сайтов можно проверить, попал ли ваш сайт в список и что нужно сделать, чтобы убрать его из списка. Также можете воспользоваться нашим инструментом, которые проверяет наличие вашего сайта сразу во многих спам-базах.

8. В поисковой выдаче нет лишних страниц

На этом шаге мы своими глазами просматриваем выдачу по сайту, чтобы удостоверится, что Google не индексирует ненужные страницы.

К таким страницам можно отнести:

- дубли страниц;

- проиндексированные страницы поиска или фильтров (кроме тех случаев, когда вы их намеренно индексируете);

- страница корзины;

- страницы картинок;

- любые страницы с информацией, которые пользователи вряд ли будут искать в поиске.

Такие страницы могут попадать в индекс как из-за:

- невнимательности разработчиков, администраторов, контент-менеджеров;

- проблем с плагинами, темами;

- взлома сайта злоумышленниками и генерации страниц для своих целей;

- построения ссылок злоумышленниками на несуществующие URL-адресса, если у вас не настроен 404 ответ сервера для таких страниц.

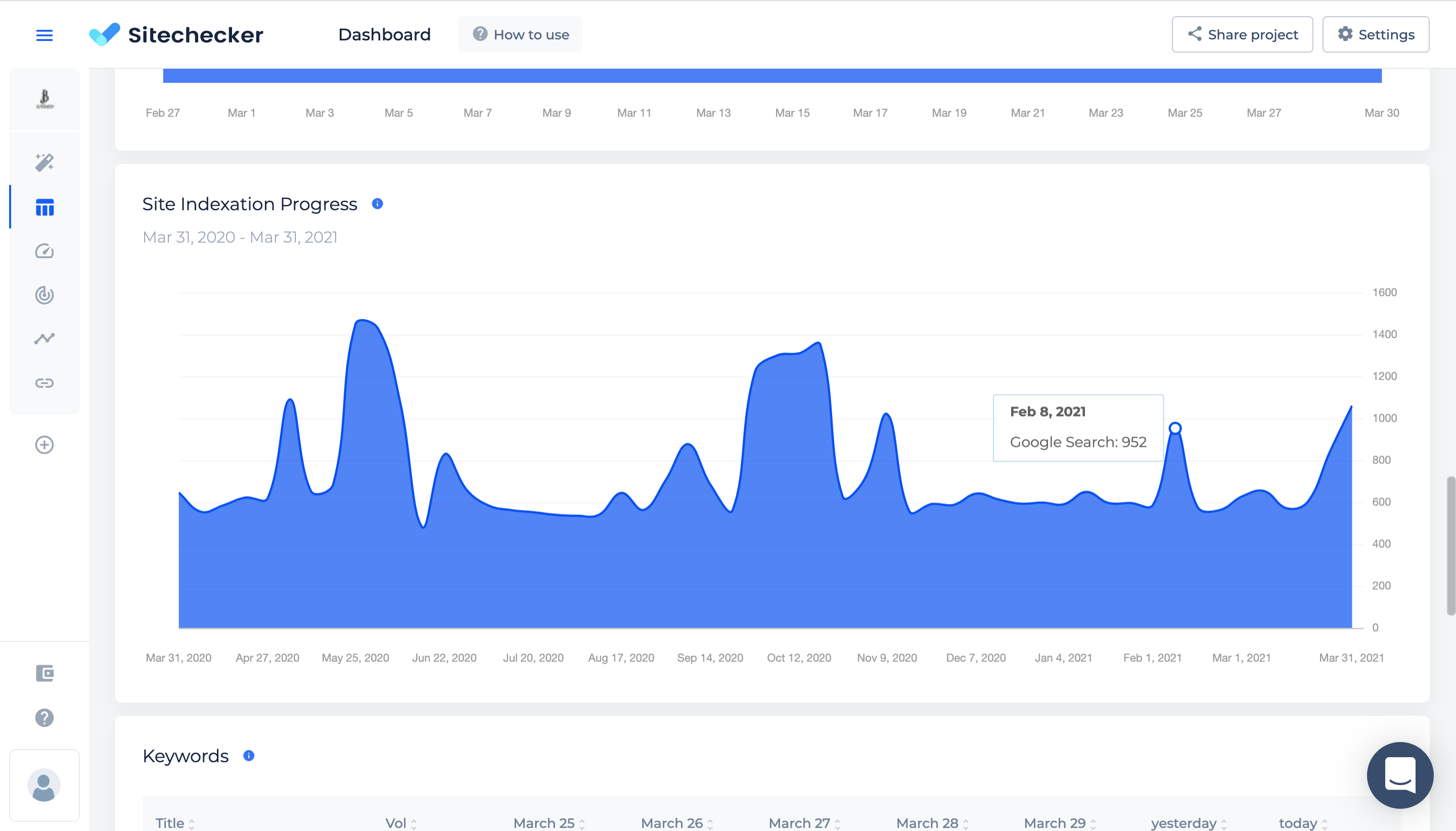

Если сайт уже показывается в поиске длительное время и генерит трафик, то важно поставить на поток отслеживание проблем с индексацией страниц. Количество страниц в индексе может расти и падать как по вашей воле (когда вы сознательно удаляете страницы или добавляете новые), так и в следствие вышеперечисленных ошибок.

В Sitechecker есть специальный график на котором вы можете оценить все ли нормально с индексацией вашего сайта. Резкие всплески страниц в индексе могут служить триггером для отдельного аудита, что нового попало в выдачу или какие страницы выпали из нее.

9. Проверьте настройки robots.txt, sitemap.xml и 404 ответ сервера

Эти настройки помогают частично застраховать сайт от вышеперечисленных проблем. Лишние страницы в индексе приносят вред не только тем, что пользователи получают негативный опыт, попав на них, но и тем, что бот Google будет меньше и реже сканировать нужные страницы.

Количество времени и ресурсов, которое робот Googlebot может затратить на один сайт, лежит в основе так называемого лимита на сканирование. Обратите внимание, что не все просканированные страницы сайта индексируются. Google их анализирует, консолидирует и определяет, нужно ли их добавлять в индекс. Лимит на сканирование зависит от двух основных факторов: скорости сканирования и потребности в сканировании.<...>

<...>Ресурсы, которые может выделить Google для сканирования того или иного сайта, рассчитываются с учетом его популярности, уникальности, ценности для пользователей, а также мощности серверов. Увеличить лимит на сканирование можно только двумя способами: выделив дополнительные ресурсы сервера для сканирования или (что гораздо важнее) повысив ценность контента, размещенного на сайте, для пользователей Google Поиска.<...>

Sitechecker поможет вам выявить отсутствие этих настроек, но пока не пропишет все условия за вас. Проследите, чтобы robots.txt файл содержал правила, которые запрещают сканирование незначимых для поиска страниц, sitemap.xml файл содержал ссылки на все значимые страницы, и при запросе несуществующей страницы сервер всегда отдавал 404 статус код.

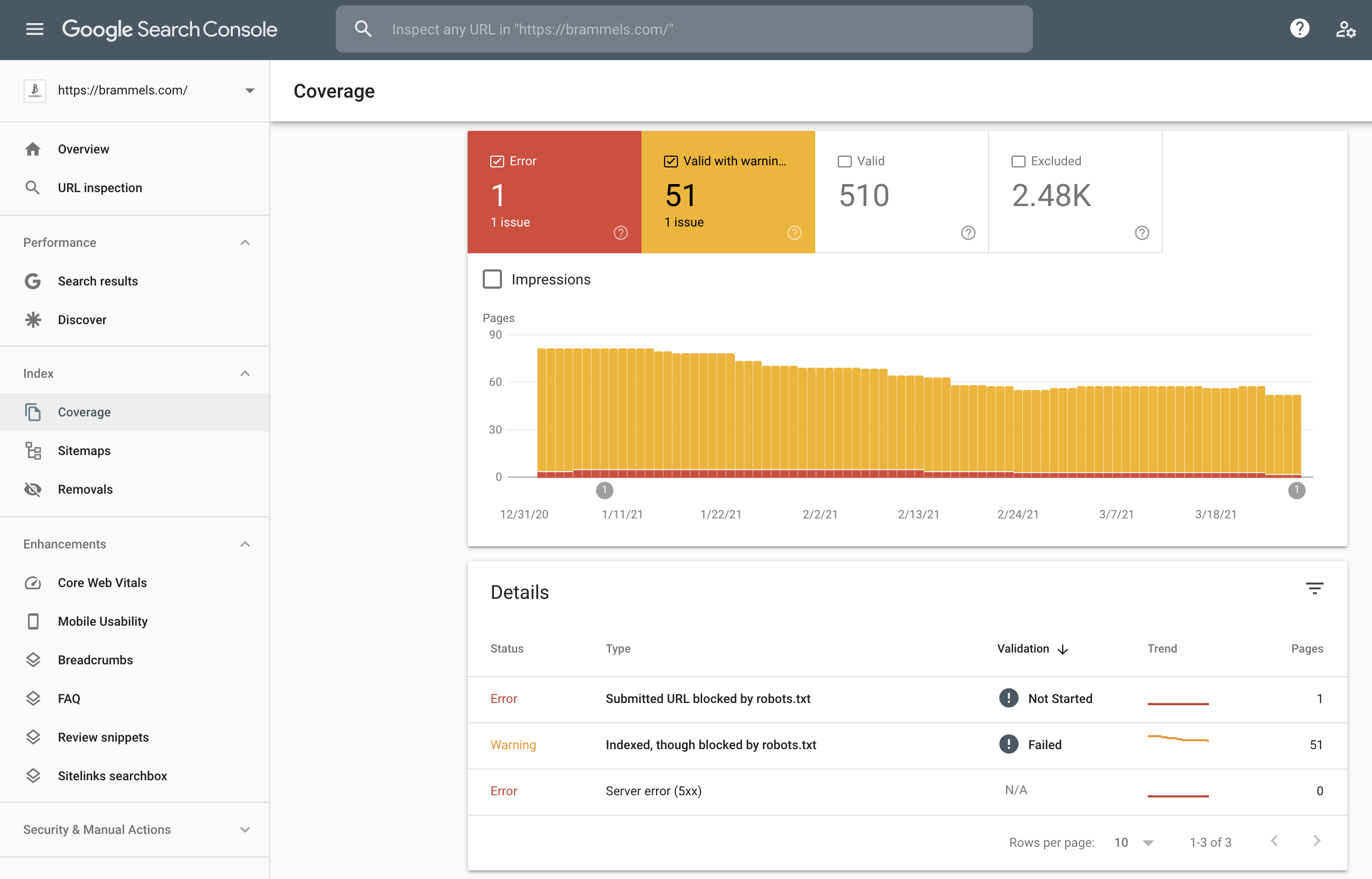

Изучите также ошибки в отчете “Покрытие” в Google Search Console, чтобы найти проблемы со сканированием и индексированием. Используйте инструкцию от Google, чтобы понять, что значит тот или иной статус в отчете.

10. Проверьте наличие и правильность тегов canonical

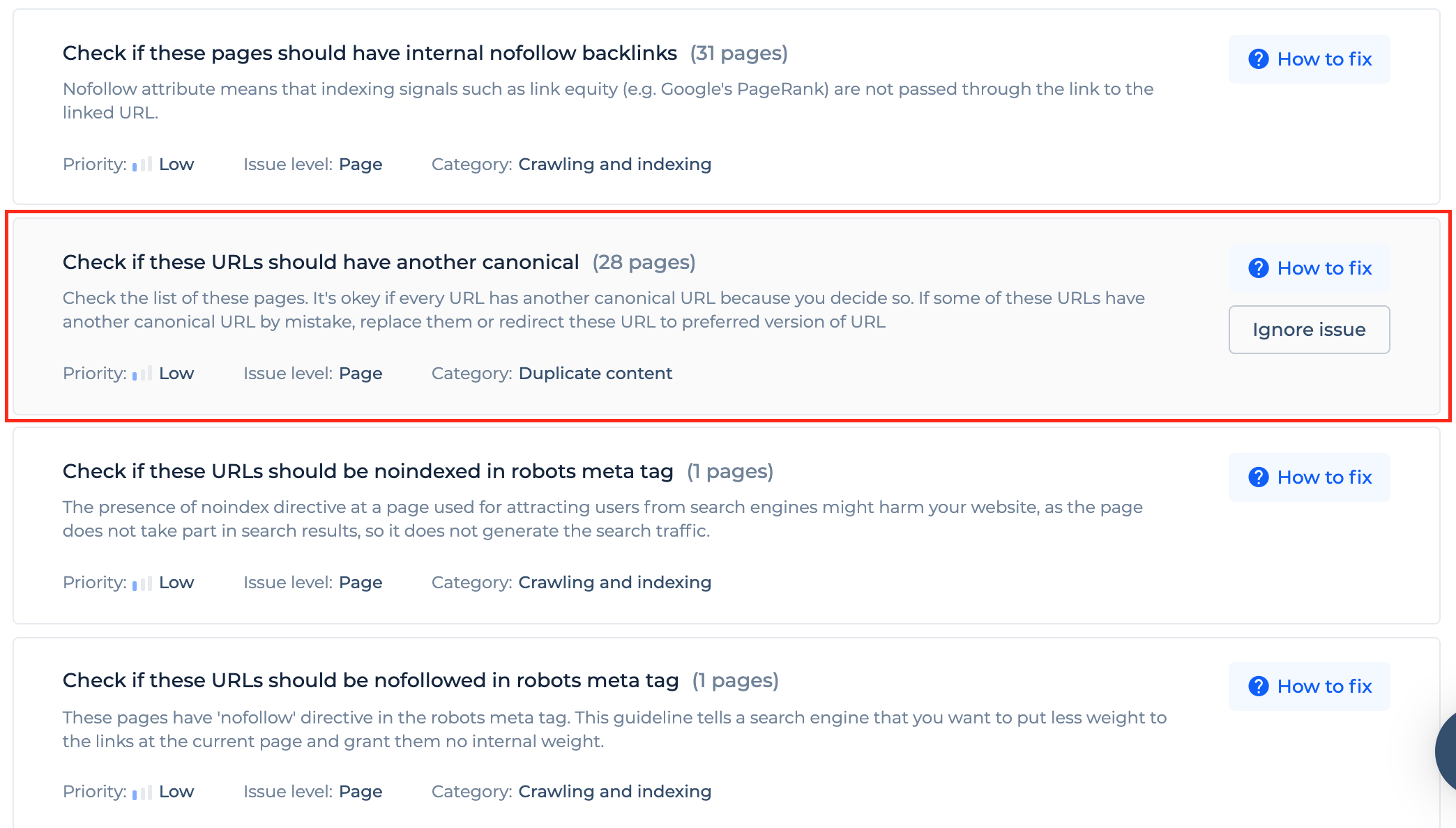

Еще одна важная настройка которая страхует вас от проблем с дублями страниц. Даже если вы не нашли дублей в процессе изучения поисковой выдачи по своему сайту, это не значит, что добавление тегов сanonical можно игнорировать.

Вы даже можете не знать:

- что у вас на сайте есть страницы, мало отличающиеся одна от другой;

- что люди ставят обратные ссылки на разные URL-адреса одной и той же страницы.

И если вы сами не выберите какая версия страницы выступает основной, а какая копией, то это сделает за вас Googlebot.

Канонические страницы выбираются по ряду критериев, также называемых сигналами. Примеры сигналов: протокол (http или https), качество страницы, присутствие URL в файле Sitemap, а также наличие атрибута rel=canonical. Даже если вы укажете Google каноническую страницу, используя описанные в этой статье способы, мы по той или иной причине можем выбрать другую.<...>

Особенно запомните последний тезис из цитаты: “даже если вы укажете Google каноническую страницу, используя описанные в этой статье способы, мы по той или иной причине можем выбрать другую”.

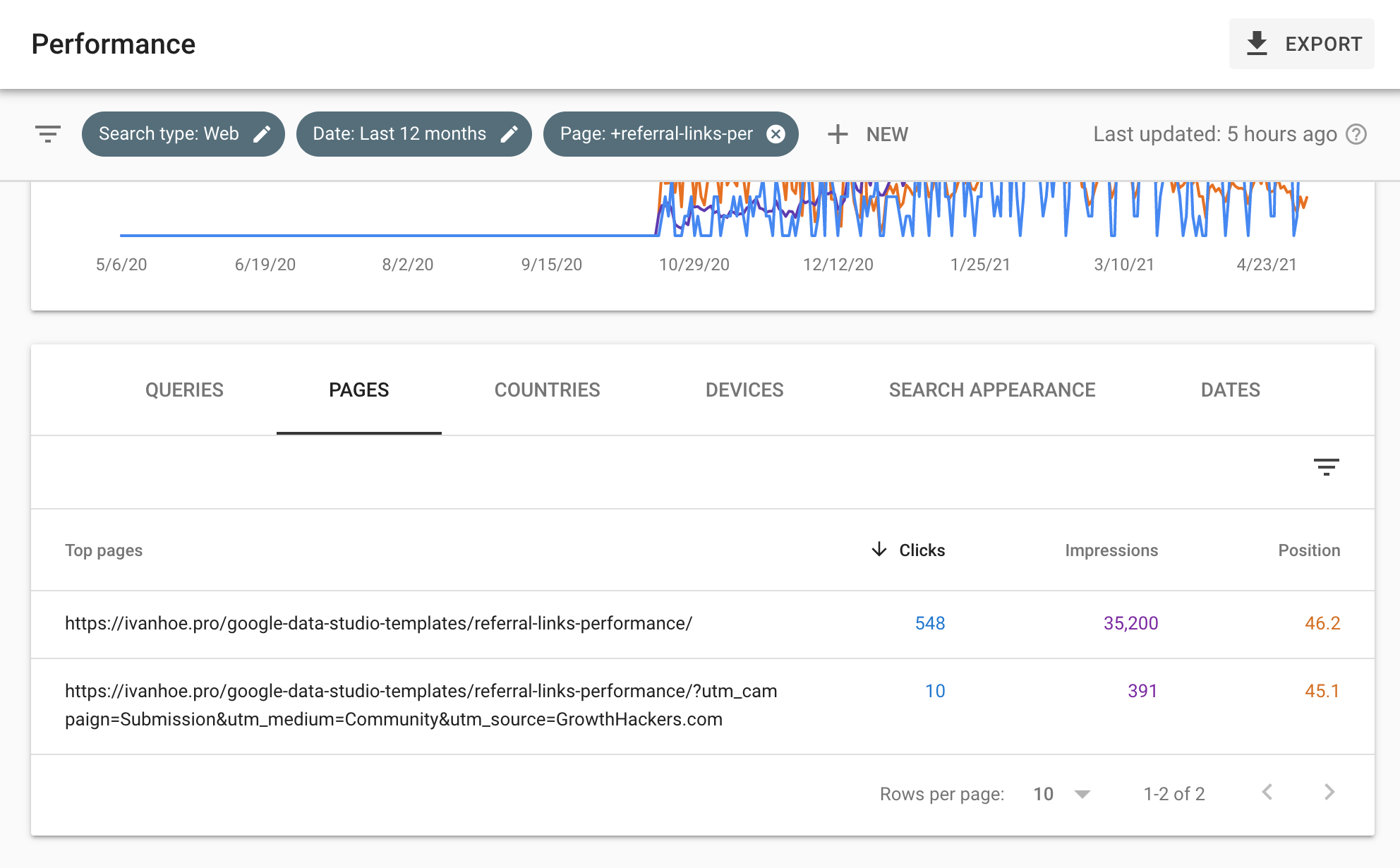

Я ощутил это на своей шкуре, когда опубликовал одну из страниц сайта на GrowthHackers. Несмотря на то, что страница содержит правильный тег canonical, Google какое-то время индексировал версию страницы с utm-меткой.

То есть, canonical является рекомендацией для бота, одним из сигналов. Его нужно использовать, но помнить и о других сигналах. Если у вас есть страницы без тега canonical, или страницы с другим тегом canonical, чем их URL адрес, Sitechecker во время аудита сайта найдет это и подскажет, что нужно сделать с ними.

11. На сайте нет битых ссылок и цепочек редиректов

Процесс работы над сайтом часто сопровождается удалением страниц, изменений их URL-адресов, объединением страниц. Эти действия приводят к тому, что на сайте появляются битые ссылки и редиректы.

Битые ссылки – это ссылки на несуществующие или неработающие страницы. Это могут быть, как ссылки на удаленные страницы, так и просто допущенные ошибки при написании адреса ссылки.

Редиректы – это перенаправление пользователя с одного адреса страницы на новый.

И битые ссылки, и редиректы при небольших количествах не особо опасны с точки зрения Googlebot. Их основная опасность заключается в ухудшении опыта пользователя: при битых ссылках посетитель сайта не может попасть на ту страницу, которую ему обещали, а при длинных цепочках редиректов он вынужден тратить больше времени на ожидание загрузки страницы.

Битые ссылки и цепочки редиректов становятся большой проблемой в том числе и с точки зрения Googlebot в двух случаях.

- Когда они находятся на ценных, трафиковых страницах. В этом случае, Google со временем удалит страницу из поисковой выдачи и вернуть её обратно мгновенно не получится.

- Когда их большое количество на сайте. Во-первых, это затрудняет сканирование, так как Google не просканировав какие-то страницы, не получит доступ к другим, на которые стоят ссылки с первых. Во-вторых, такие страницы сьедают краулинговый бюджет, и соответственно его недополучают другие ценные страницы.

Поэтому, так же как и доступность главной страницы, важно постоянно отслеживать появление новых битых ссылок и редиректов, чтобы мгновенно исправлять критические ошибки.

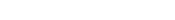

12. Сайт быстро загружается

Google еще в 2010 году опубликовал новость о включении параметра скорости сайта в формулу ранжирования. Но и наши практические опыты и заявление сотрудника Google Гэри Илша в 2020 году показали, что влияние этого фактора незначительное.

Основная ценность высокой скорости сайта состоит в том, что она помогает лучше конвертировать тех пользователей, что уже посетили ваш сайт, а не обгонять другие сайты в выдаче.

Несмотря на это, хорошая скорость вам все равно нужна, если вы собираетесь соревноватся за первые места. Чем больше у вас будет трафика, тем выгоднее вкладывать в ускорение сайта, так как это напрямую влияет на количество конверсий и доход.

Для Mobify уменьшение скорости загрузки домашней страницы на каждые 100 мс привело к увеличению конверсии на основе сеанса на 1,11%, что дало среднегодовой прирост дохода почти на 380000 долларов. Кроме того, снижение скорости загрузки страницы оформления заказа на 100 мс привело к увеличению конверсии на основе сеанса на 1,55%, что, в свою очередь, привело к среднегодовому увеличению дохода почти на 530 000 долларов США.<...>

Чтобы выявить проблемы со скоростью используйте такие инструменты.

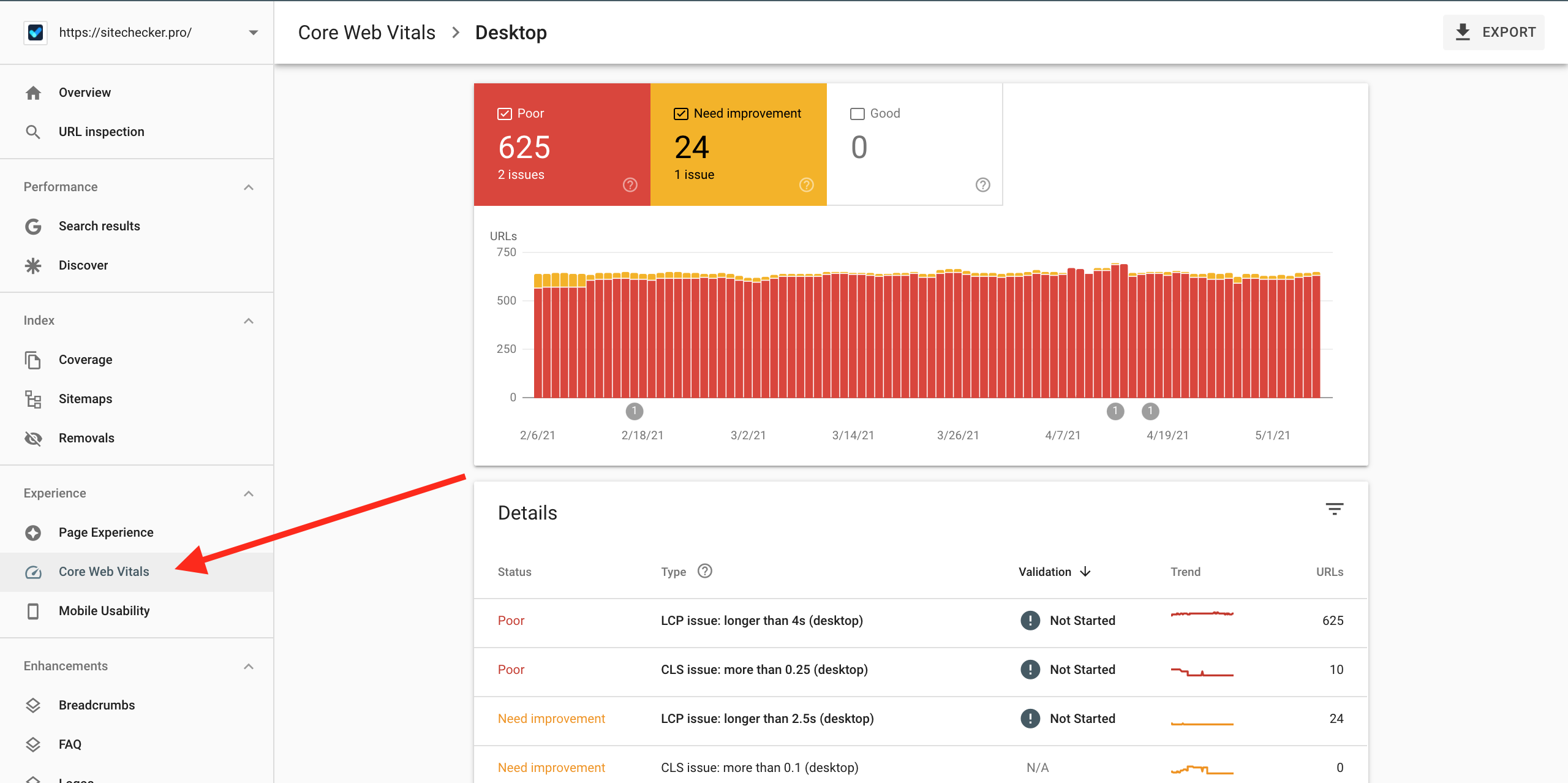

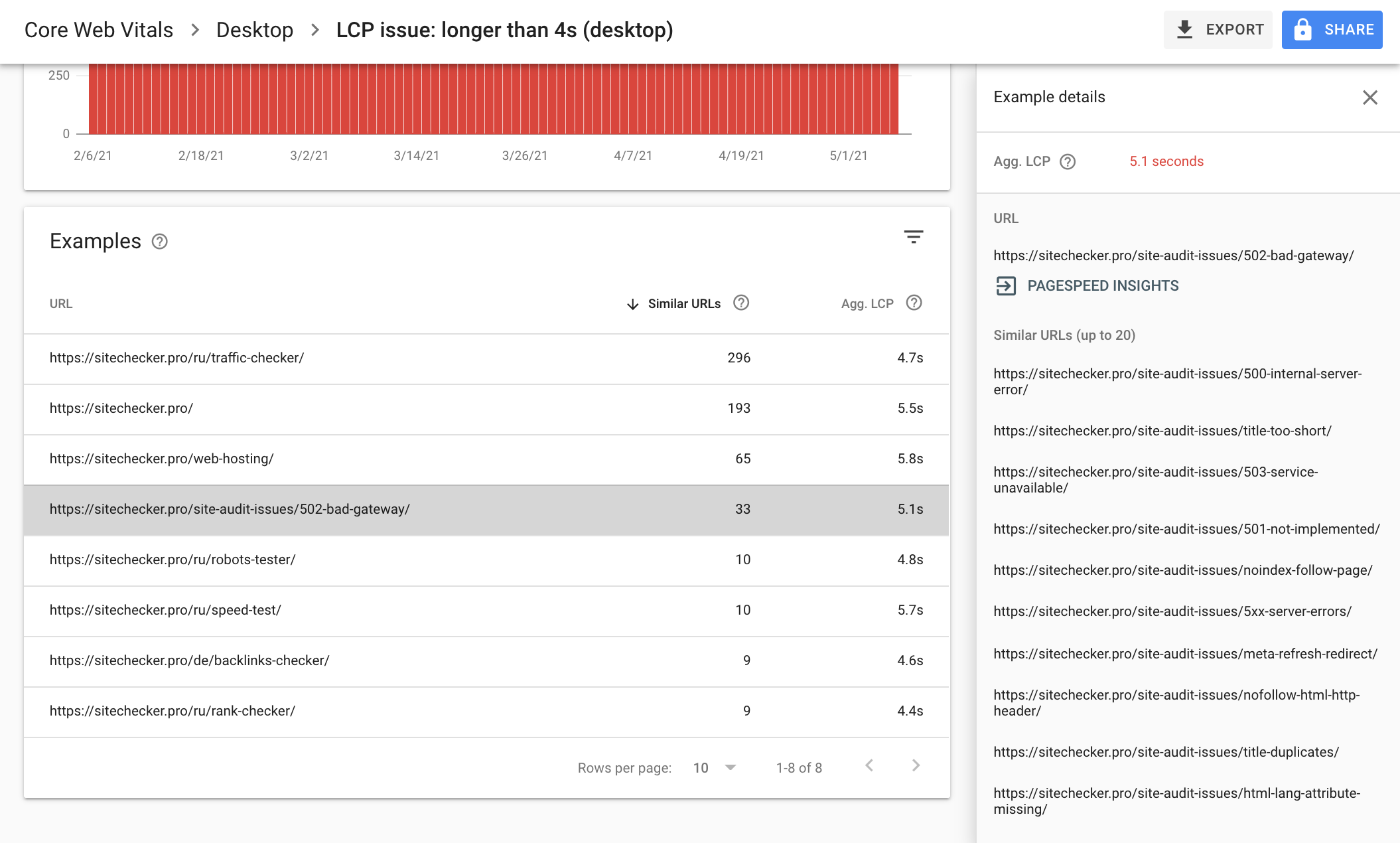

Отчет по Core Web Vitals в Google Search Console

Этот отчет особенно удобен тем, что инструмент делит проблемные страницы на группы. Так вы сразу можете предположить какие общие характеристики всех страниц с одной группы нужно оптимизировать, чтоб улучшить их скорость.

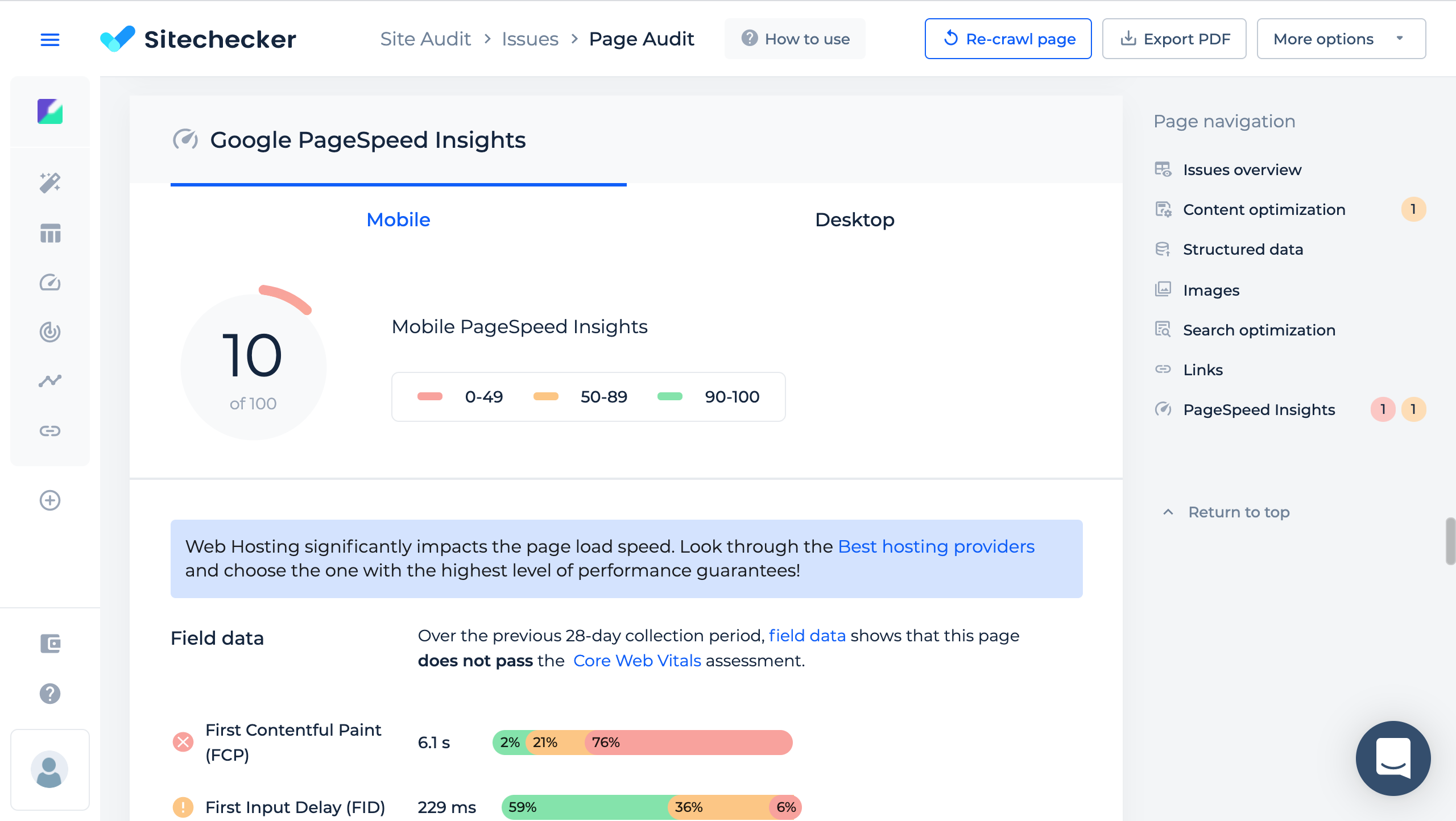

Проверка скорости страницы в Google PageSpeed Insights

Ценность отчета PageSpeed Insights в том, что он содержит точную информацию о картинках, скриптах, стилях и других файлах, которые негативно влияют на скорость загрузки страницы, и подсказывает что нужно сделать с этими файлами, чтобы ускорить загрузку страницы.

Мы используем Google PageSpeed Insights API в инструменте SEO анализа страниц, так что вы можете исследовать проблемы скорости вместе с другими проблемами страницы в одном месте.

13. На сайте настроены человекопонятные адреса страниц

Человекопонятные урлы (ЧПУ) – это такие адреса страниц, которые помогают пользователям понять, какой контент находится на странице, еще до её посещения. Это особенно ценно, когда кроме адреса страницы у пользователя нет никакой дополнительной информации о ней: ни заголовка, ни описания, ни картинки.

Кроме этого ЧПУ помогают:

- Запоминать ценные страницы и легко к ним возвращаться;

- Быстрее перемещаться по сайтам;

- Удобнее делится ссылкой с другими людьми.

Создание адреса страниц на основе ключевых слов также помогает поисковому боту быстрее распознать содержание страницы, но не дает прироста в позициях.

Пример длинного и непонятного URL:

https://sitechecker.pro/folder1/89746282/48392239/file123/

Пример дружественного для пользователя URL:

https://sitechecker.pro/site-audit-issues/twitter-card-incomplete/

При этом помните, что адреса страниц на кириллице, хоть и понятны для пользователя, не все приложения и сайты их распознают.

В поисковой выдаче и строке браузера адрес вашей страницы может выглядеть вот так:

https://ru.wikipedia.org/wiki/Менеджмент

А при копировании ссылки и отправке её почтой или в мессенджере вот так:

https://ru.wikipedia.org/wiki/%D0%9C%D0%B5%D0%BD%D0% B5%D0%B4%D0%B6%D0%BC%D0%B5%D0%BD%D1%82

Поэтому я рекомендую для страниц с кириллическим контентом все равно использовать URL-адреса на латинице: через транскрибацию адреса или полный перевод на английский.

14. На сайте удобная навигация для пользователей

Удобная навигация на сайте выражается в том, что:

- пользователь может быстро найти информацию, которую его интересует касательно услуги, продукта, компании;

- пользователь по навигации понимает какие возможности на сайте его ожидают.

В зависимости от ниши удобство навигации можно увеличивать самыми разными элементами: строка поиска, выпадающее меню с категориями продуктов, хлебная крошка, размещение самых важных страниц в хедере, удобная фильтрация в интернет-магазинах и тому подобное.

Аудит удобства сайта для пользователей – это отдельное большое направление. Его проводят как правило для поиска точек улучшения конверсии, но он также важен и в рамках SEO аудита сайта. Если навигация на сайте плохая, то после перехода на сайт с поиска, пользователи будут часто возвращатся обратно в поисковую выдачу, чтобы найти сайты с более удобной навигацией. А возврат в поисковую выдачу – это сигнал для алгоритма, что сайт плохо решает задачу пользователя и его позиции нужно снизить.

Чтобы оценить удобство навигации по сайту, поставьте себя на место пользователя и попробуйте достигнуть желанного результата на своем сайте и на сайтах конкурентов. Запишите, что вам мешало и помогало в этом процессе на каждом сайте. Так вы получите первый список улучшений. Дополнительно закажите такую услугу у профессионалов на биржах фриланса.

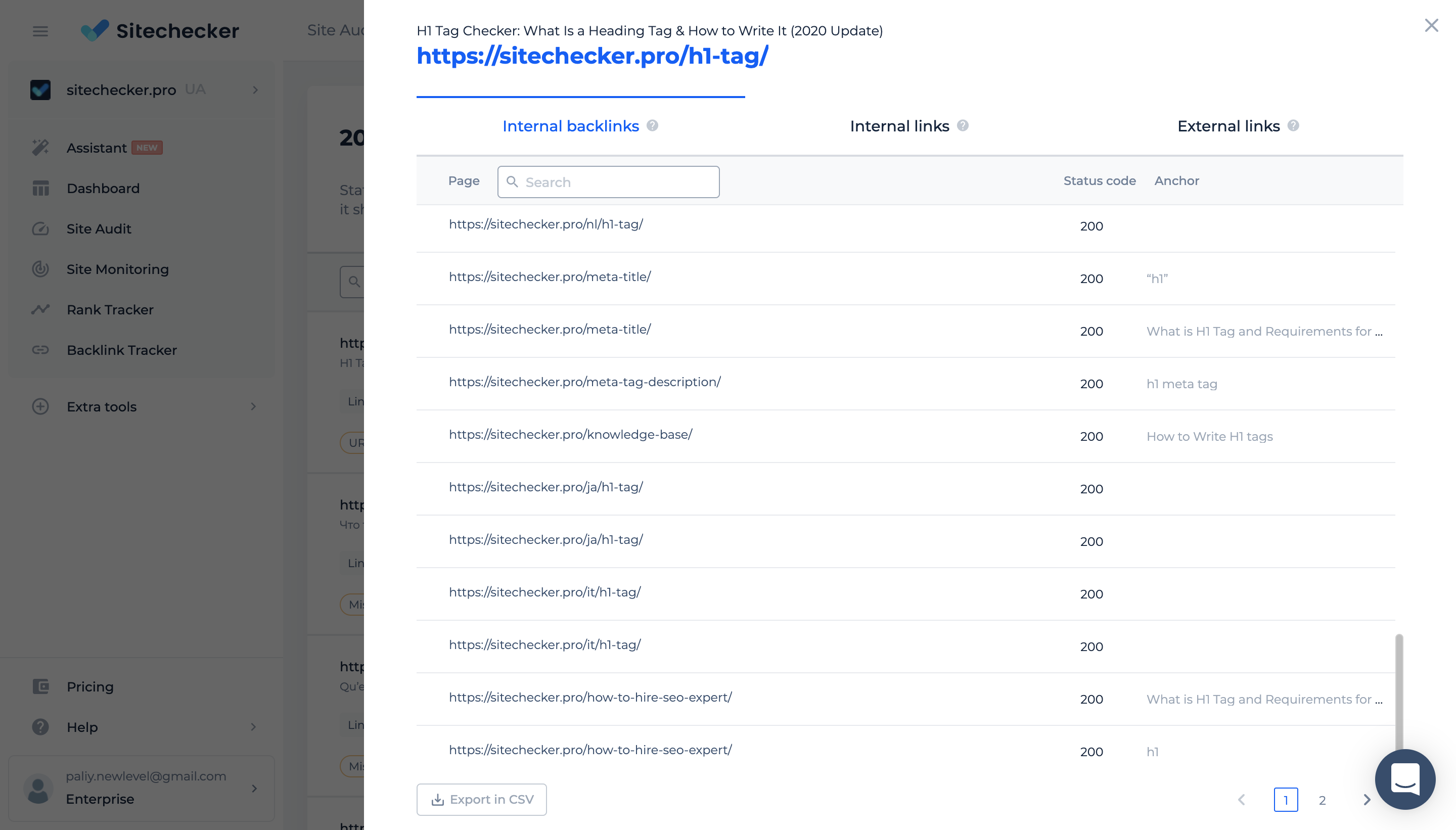

15. На сайте правильно организованная ссылочная структура для Google бота

Хорошая ссылочная структура включает несколько правил.

Наличие внутренних ссылок на все страницы, которые мы хотим проиндексировать.

Если у вас есть страницы на которые нет ни одной внутренней ссылки с других страниц, то бот Google может пропустить их и не просканировать. Внутренние ссылки это не единственный источник получения данных о всех существующих страницах для бота (есть еще файл sitemap.xml и обратные ссылки с внешних сайтов), но это самый надежный способ рассказать боту о сущестовании новой страницы и необходимости сканировать ее регулярно.

Страницы без входящих внутренних ссылок еще называют страницы-сироты. Наш краулер в Site Audit поможет их найти. Если какие-то страницы есть в файле sitemap, но на них нет внутренних ссылок, то мы поместим их категорию Orphan URLs. Такие страницы нужно удалить, если вы так и хотите их оставить вне индекса, либо средиректить, либо поставить на них внутренние ссылки.

Размещение самых ценных страниц ближе к главной странице и большее количество внутренних ссылок на ценные страницы, чем на другие страницы.

Это важно, так как бот Google оценивает ссылочный вес страницы по этим факторам. Если малоценные страницы будут иметь самый большой ссылочный вес, то ценные страницы будут занимать более низкие позиции в выдаче, чем могли бы, если бы вы направили основной вес на них.

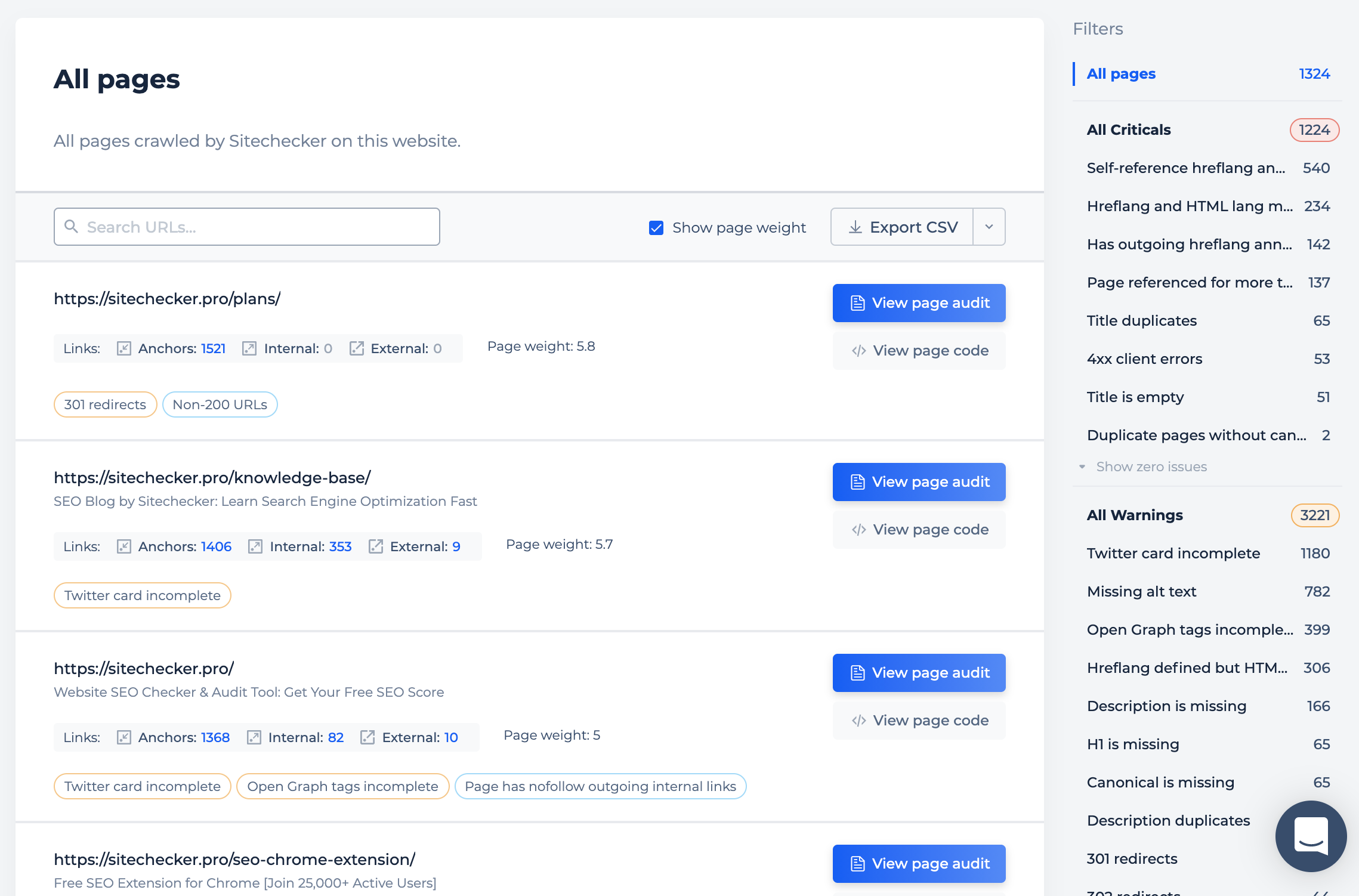

У нас в Site Audit есть возможность посмотреть ссылочный вес всех страниц (Page Weight). Для его расчета мы используем стандартную формулу PageRank от Google, но без учета анкоров и внешних ссылок.

Используйте эти данные, чтобы проверить правильные ли страницы у вас на сайте имеют самый высокий вес.

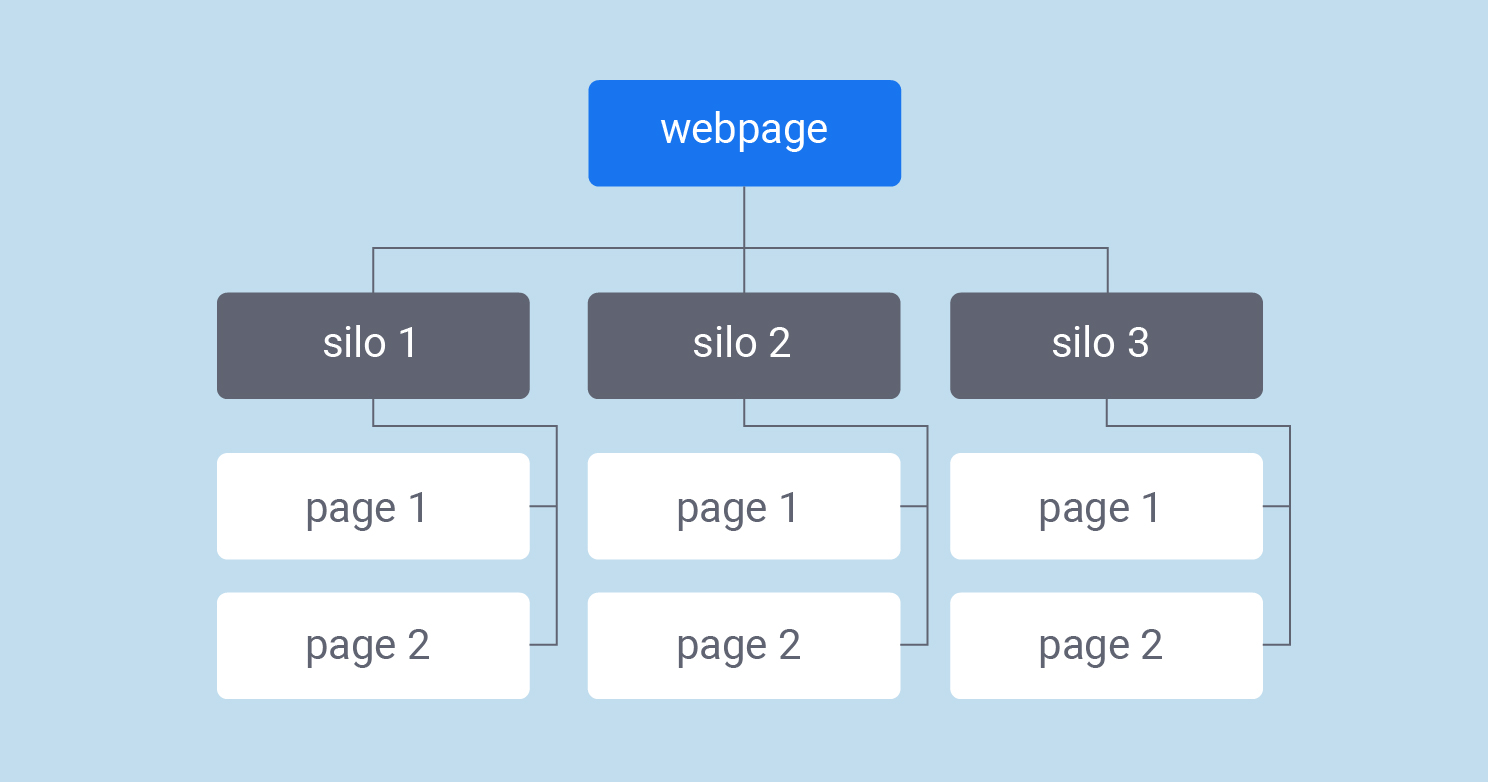

Третьим, но не обязательным пунктом выступает специальная структура перелинковки – Silo. Это такая перелинковка, при которой мы создаем на сайте изолированные друг от друга кластеры страниц, и страницы с одного кластера никогда не ссылаются на страницы с другого кластера.

Такой метод актуален для сайтов, которые содержат контент на разные тематики, а не только на одну специализированную. Брюс Клей считает, что это одна из самых недооцененных техник в оптимизации сайтов. Можете использовать его чек-лист для внедрения такой структуры у себя на сайте.

16. И пользователи, и бот Google понимают содержание страницы

Понимание страницы ботом Google выражается в том, что он получает достаточно информации о том, какие какие проблемы пользователя может решить страница и ранжирует ее по тем ключевым словам, под которые мы оптимизировали страницу.

Пользователь оценивает содержание страницы в три этапа:

- по сниппету в поисковой выдаче, социальной сети, мессенджере;

- по информации на первом экране при посещении страницы;

- по изучению всего контента на странице.

Рассмотрим ключевые элементы, которые помогают донести содержание и цель страницы до поисковых ботов и людей.

Теги title и description

Тег title и тег description выступают одними из факторов ранжирования. Бот Google придает больший вес словам в этих тегах, чем словам в контенте, когда оценивает задачу страницы.

Также Google чаще всего именно из этих тегов формирует сниппет страницы в поисковой выдаче. Поэтому хороший title и description это краткое обещание для пользователя, которое должно привлечь его внимание и показать, что он получит, если перейдет на страницу.

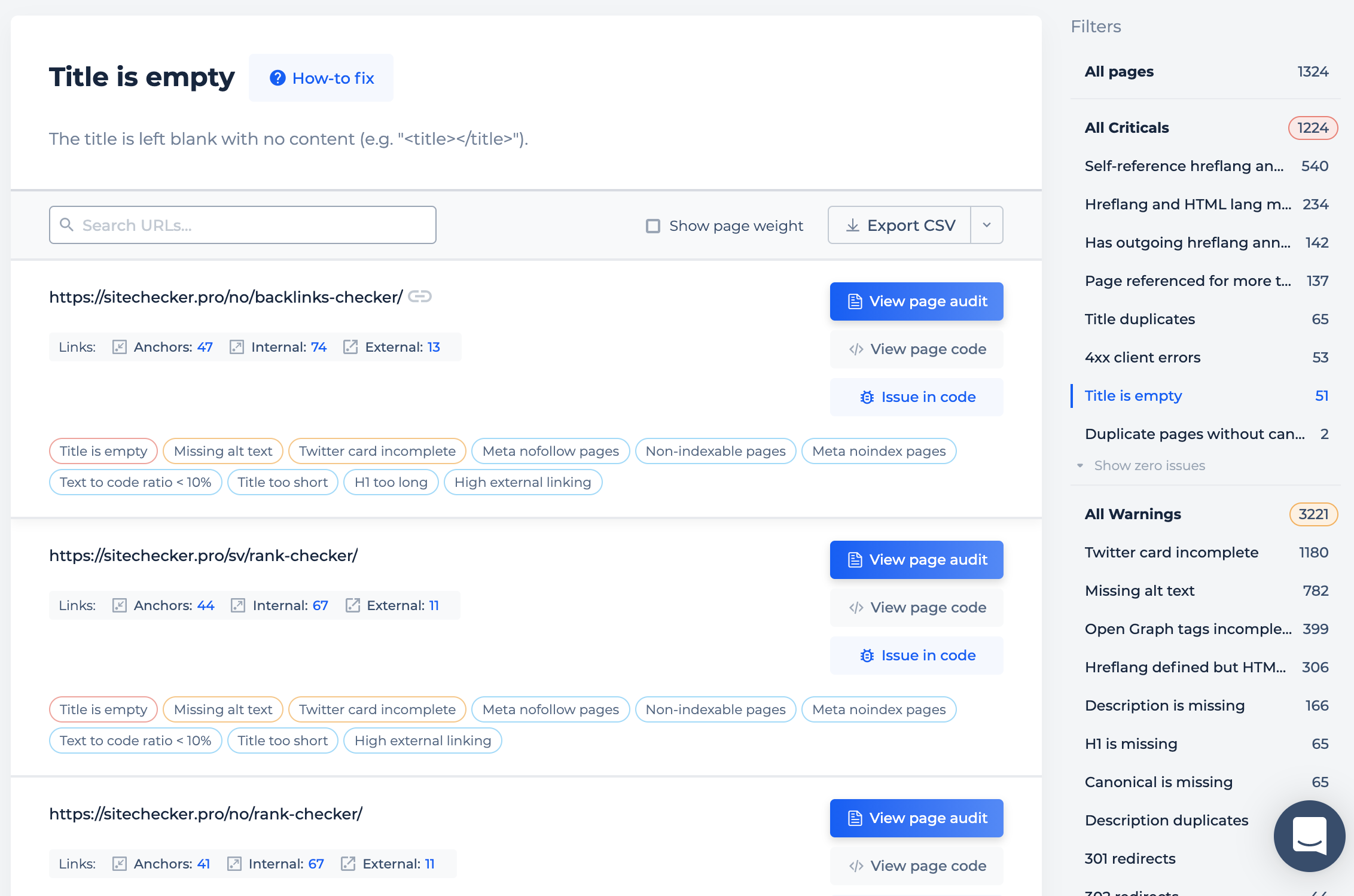

Наш Site Audit поможет вам найти страницы, где этих тегов нет, или они пустые, дублированные, слишком длинные, короткие.

Заголовки

Заголовки могут быть выделены визуально, но не размечены по важности для Google и наоборот. Визуальное выделение помогает пользователем быстрее сканировать текст и видеть смысловое разделение текста. Разметка для Google помогает ему также лучше понять содержание страницы. Ключевым словам, которые находятся в размеченных заголовках придается больший вес при оценке релевантности страницы, чем в обычном тексте.

Заголовок H1 – самый важный заголовок, близкий по значению к тегу title. Далее идут заголовки h2-h6. Каждый следующий заголовок имеет меньшее значение, чем предыдущий.

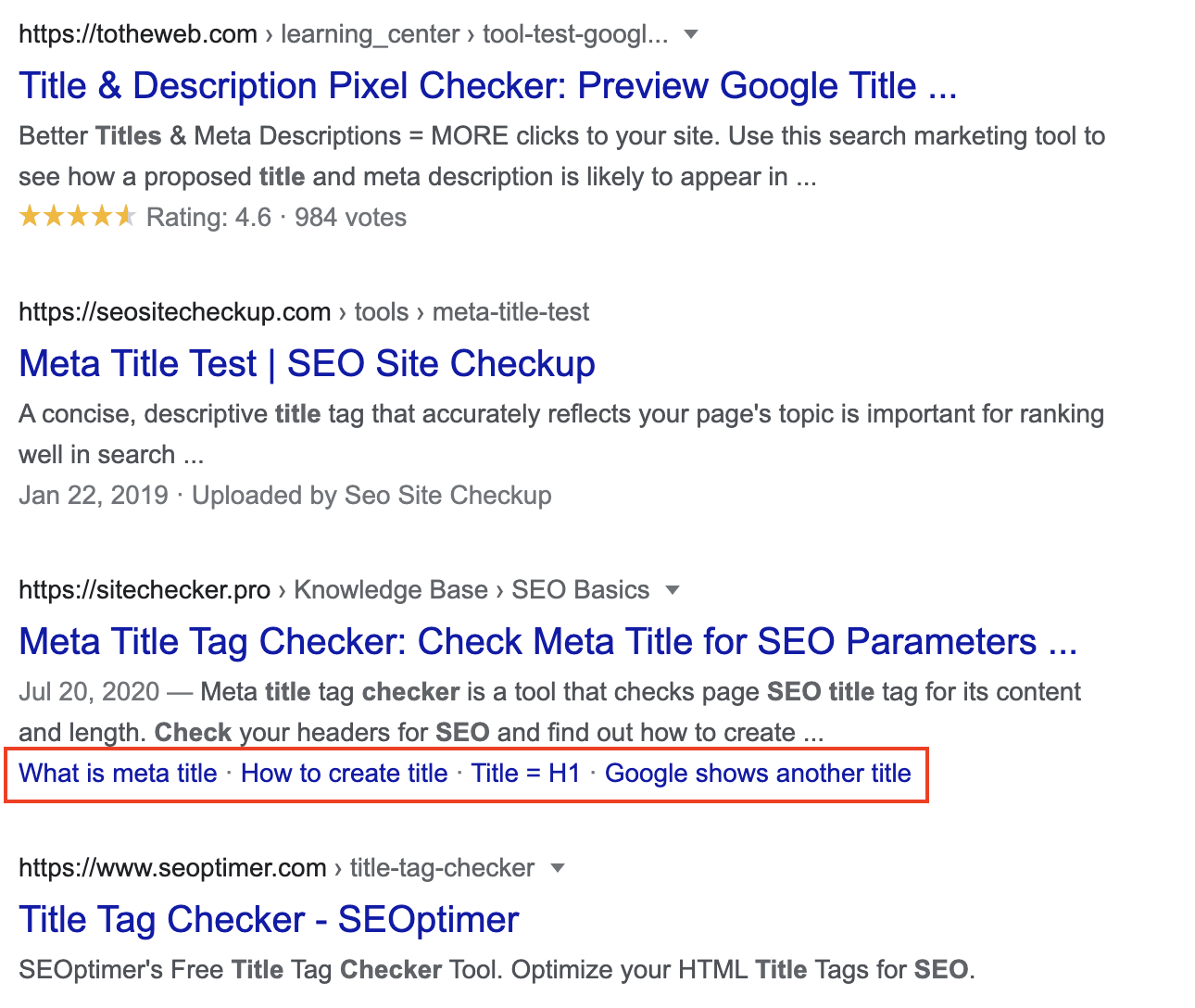

Хорошей практикой является публиковать список подзаголовков страницы в самом начале, как в книге. Это дает возможность пользователю оценить, есть ли нужная ему информация на странице и перейти сразу к ней в один клик. Дополнительным бонусом Google иногда отображает такие быстрые ссылки в сниппете страницы, что визуально увеличивает ваш сниппет и дает больше информации пользователю.

Структурированная разметка

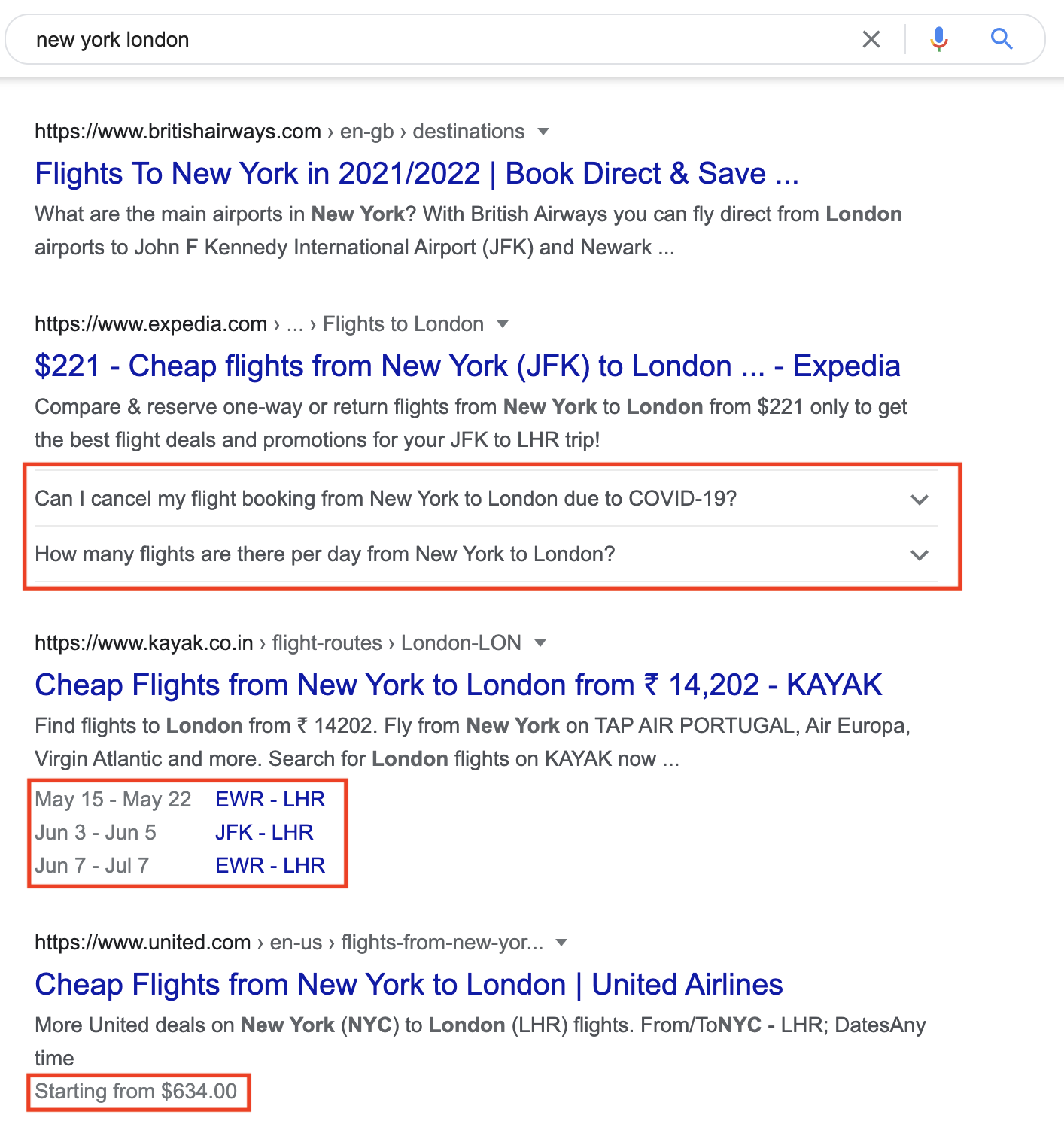

Структурированные данные помогают боту Google еще лучше понять содержание вашей страницы и сформировать на основе разметки дополнительнные элементы сниппета. Например, на скриншоте ниже видно пример использования разметки FAQ, событий и цены.

Используйте эту инструкцию от Google, чтобы понять как работают структурированные данные и выбрать ценные для вашего сайта элементы разметки. И добавьте себе в закладки инструмент Google Rich Results Test, чтобы после внедрения проверить разметку на ошибки.

Теги социальных сетей

К таким тегам относят Open Graph Protocol и Twitter Cards. Они помогают сделать привлекательнее сниппет страницы в социальных сетях и мессенджерах, что напрямую влияет на ее кликабельность. Доля социальных сетей во времени, которое тратят пользователи в интернете, растет. Поэтому есть смысл добавить эти теги на все ценные страницы.

Можете сравнить ниже привлекательность сниппета, где подтянулась картинка, и где ее нет.

Анкоры ссылок

Анкорный текст ссылок выступает одним из ключевых факторов ранжирования, так как помогает Google лучше понять содержание страницы. Используйте такие фразы, в анкорном тексте, которые кратко передают содержание страницы, на которую стоит ссылка. Это ценно не только для бота, но и для пользователей, так как они заранее понимают, какая информация стоит за страницей и будет ли она им интересна.

Наш Site Audit поможет вам найти ссылки без анкорного текста или с однообразным, нерелевантным текстом.

Большую часть всех перечисленных параметров по странице вы можете проверять в один клик с помощью расширения Sitechecker в Google Chrome.

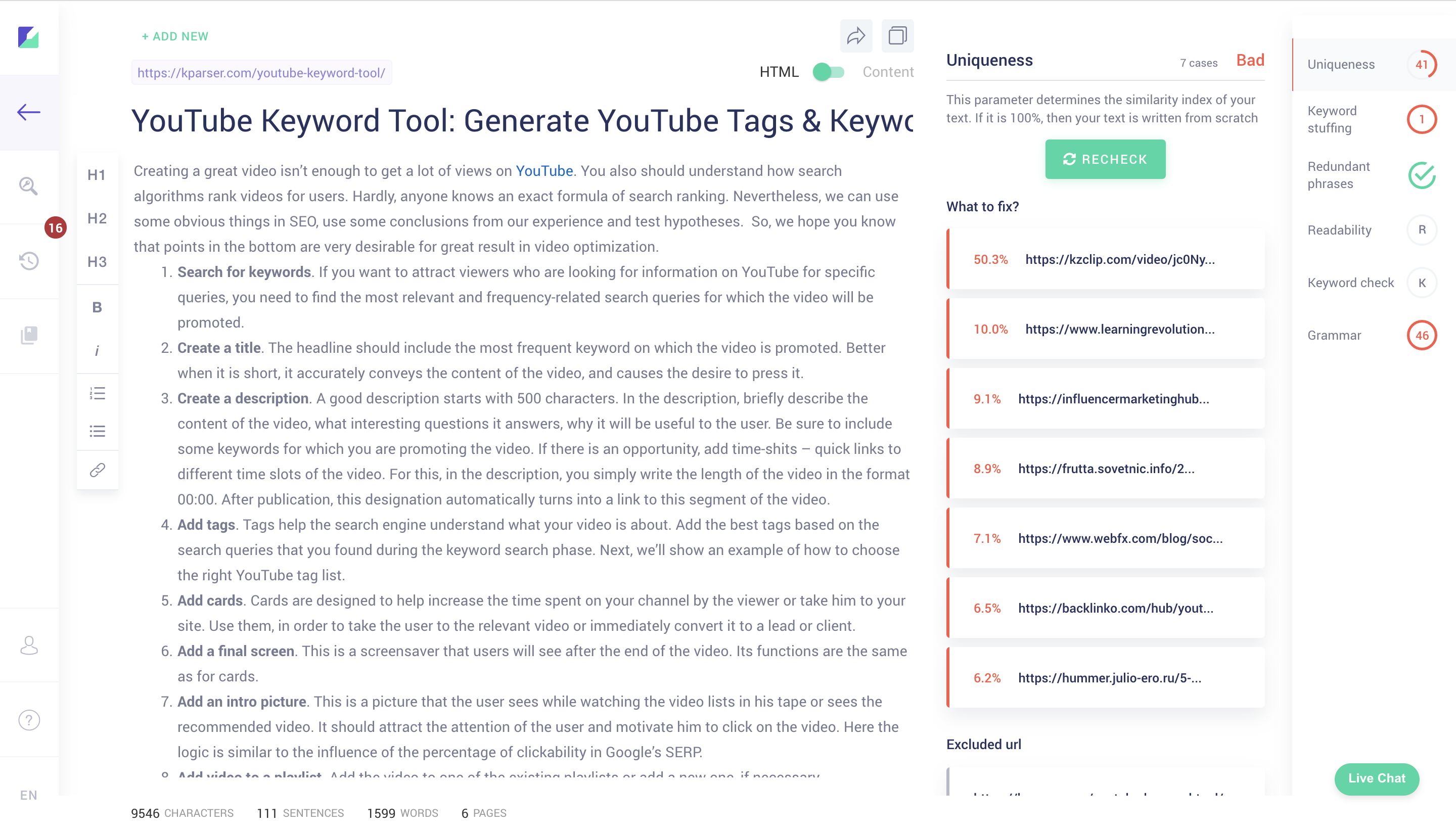

17. Проверка текста на уникальность, читабельность, грамматику, переспам

Хороший текст – это текст, который приносит трафик с органического поиска и хорошо конвертирует пользователей в ценное для бизнеса действие. Вот какие, параметры нужно проверять, чтобы удостоверится, что у вас хороший текст.

Уникальность

Важно, чтобы у вас были уникальные страницы не только в рамках своего сайта, но и по сравнению с другими сайтами в интернете. Кто-то может забрать ваш текст себе и Google посчитает оригинальным источником не ваш сайт. Такое часто бывает, так как у Google нет отлаженного механизма определения первоисточника.

Читабельность

Помогает проверить насколько легок текст для понимания пользователями. Основная ценность хорошей читабельности – это лучшая конверсия в целевое действие.

Грамматика

Джон Мюллер в одном из своих видео уточнил, что Google не проверяет текст на грамматику и не снижает позиции за грамматические ошибки. Но грамматика важна в глазах пользователя. Поэтому для ключевых страниц, которые приносят вам трафик и конверсии есть смысл ее проверять.

Использование ключевых слов

Проблемы с использованием ключевых слов могут быть двух видов:

- переспам, когда вы используете слишком много ключевых слов;

- недостаточное количество и разнобразие ключевых слов, которые касаются тематики страницы.

Все эти параметры можно проверить в нашем другом инструменте – Copywritely. Вы можете вставить как текст, так и просто URL-адресс опубликованной страницы и получить список всех ошибок контента в одном месте.

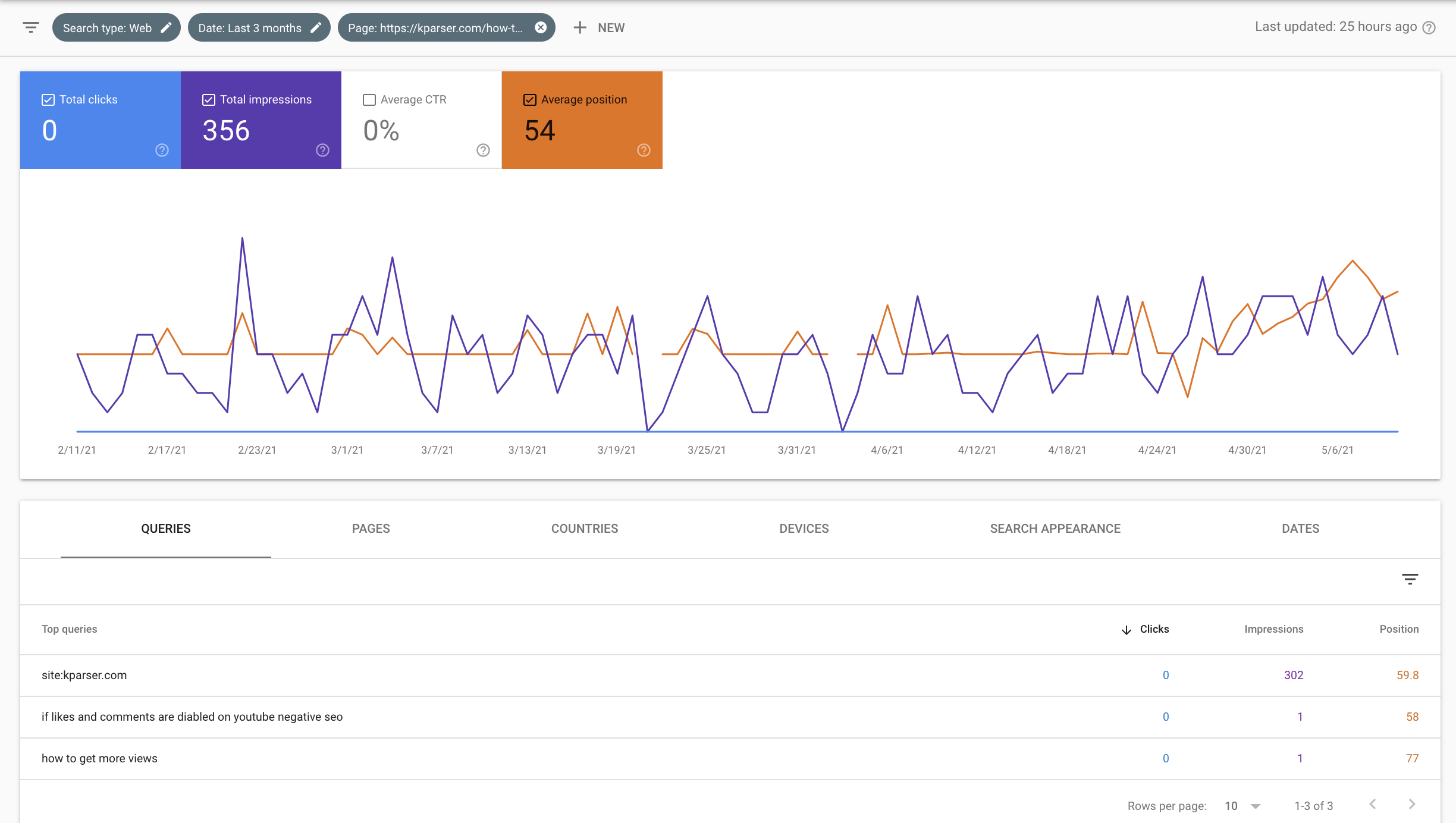

18. Поиск бесперспективных и каннибализированных страниц

Бесперспективные страницы

Это как правило страницы с небольшим количеством контента или страницы, которые Google, по какой-то причине не ранжирует по нужным нам ключевым словам, даже если контента на странице достаточно.

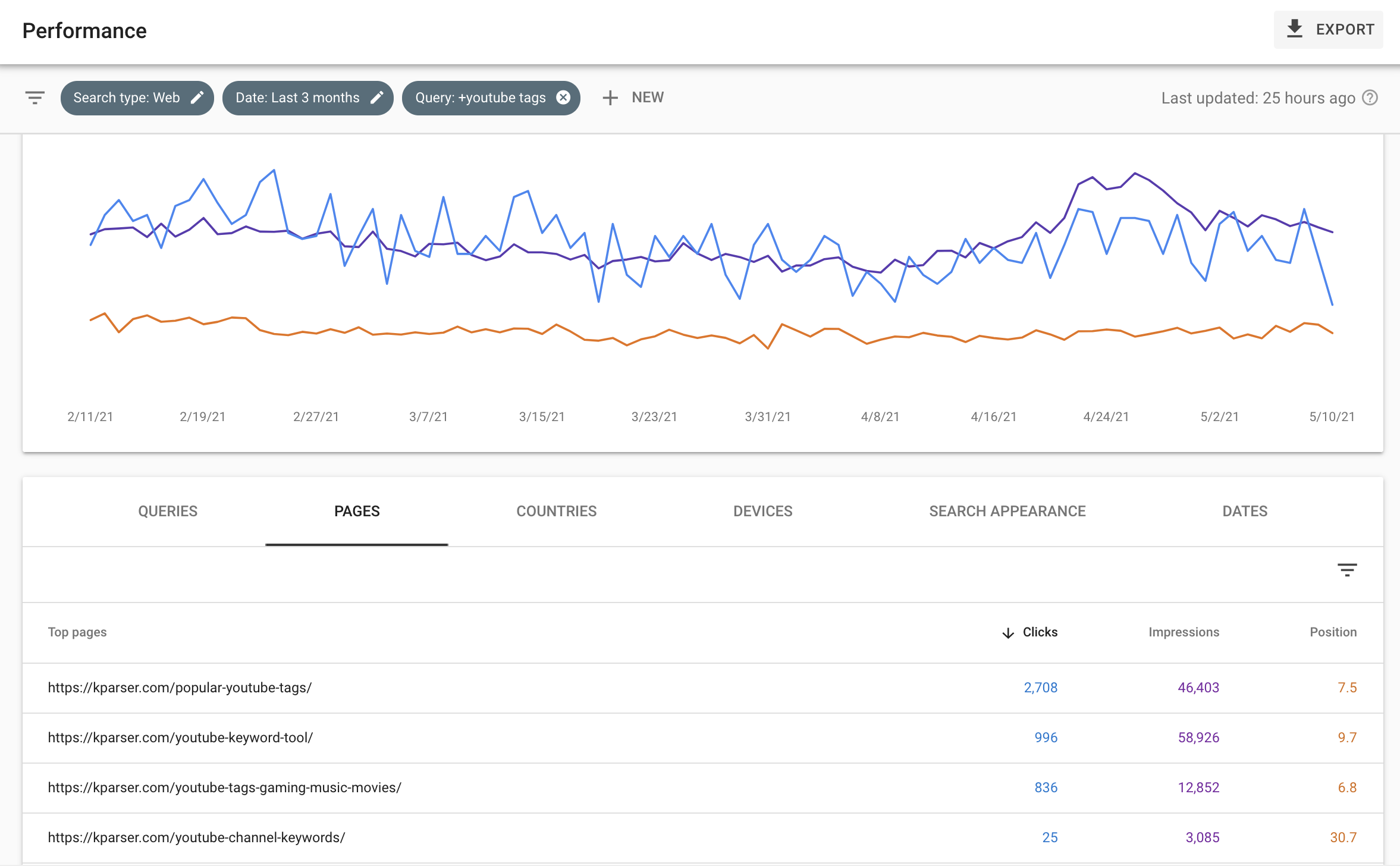

Вот скриншот типичной бесперспективной страницы – https://kparser.com/how-to-get-more-views-on-youtube/. Контент на ней плохо оформлен и давно не обновлялся. Есть смысл либо средиректить ее на близкую по тематике страницу, либо полностью переписать контент.

Чтобы найти такие страницы у себя в Google Search Console, перейдите в отчет по результатам поиска и отсортируйте страницы по количеству показов. Среди страниц с наименьшим количеством показов будут и малополезные с точки зрения Google страницы. Обращайте внимание на то сколько страница существует, сколько собрала показов и по скольким ключевым словам ранжируется. Если она в индексе больше 3 месяцев, но ранжируется всего по 1-2 ключевым словам и имеет мало показов, то вероятнее всего страница проблемная.

Работать над такими страницами имеет смысл после заявлений сотрудника Google о влиянии слабых страниц на общий рейтинг сайта.

Я проводил такой эксперимент на одном из сайтов. Удалил, средиректил или объединил все слабые страницы и это действительно дало результат в виде роста позиций для сильных страниц.

Каннибализированные страницы

Это страницы, которые ранжируются по одним и тем же ключевым словам. Если у вас таких страниц несколько и они обе стоят в топе поисковой выдачи, то отлично. Но если таких страниц больше и ни одна из них не занимает первые места, возможно, что Google не может определить какая из-них более релевантная.

Дополнительной опасностью таких страниц выступает разделение ссылочного веса на две страницы. Кто-то то будет ставить ссылки на одну страницу, кто-то на другую, и таким образом авторитетность каждой страницы будет ниже, чем могла быть у одной единственной страницы.

Чтобы найти такие страницы, вбейте ключевое слово в фильтр внутри Google Search Console и посмотрите какие страницы по нему ранжируются. Если страниц больше двух и все они стоят за 10-20 позицией, есть смысл исследовать контент этих страниц, их внутренние и внешние обратные ссылки. Вероятно, что они соревнуются между собой.

Если вы увидели, что проблема есть, то более слабые страницы, нужно либо средиректить на более сильную, либо переписать их контент так, чтобы они ранжировались по другим запросам.

19. Поиск самых ценных страниц

Самые ценные страницы можно определять по разному в зависимости от типа сайта:

- по доходу, если настроено отслеживание Ecommerce Revenue или Goal Value;

- по конверсиям в виде транзакций или достижений цели;

- по количеству трафика (актуально для СМИ, блогов или сайтов, где не настроено отслеживание конверсий)

- по количеству показов и близости к топу поисковой выдачи, если у страниц еще нет кликов, а есть только показы.

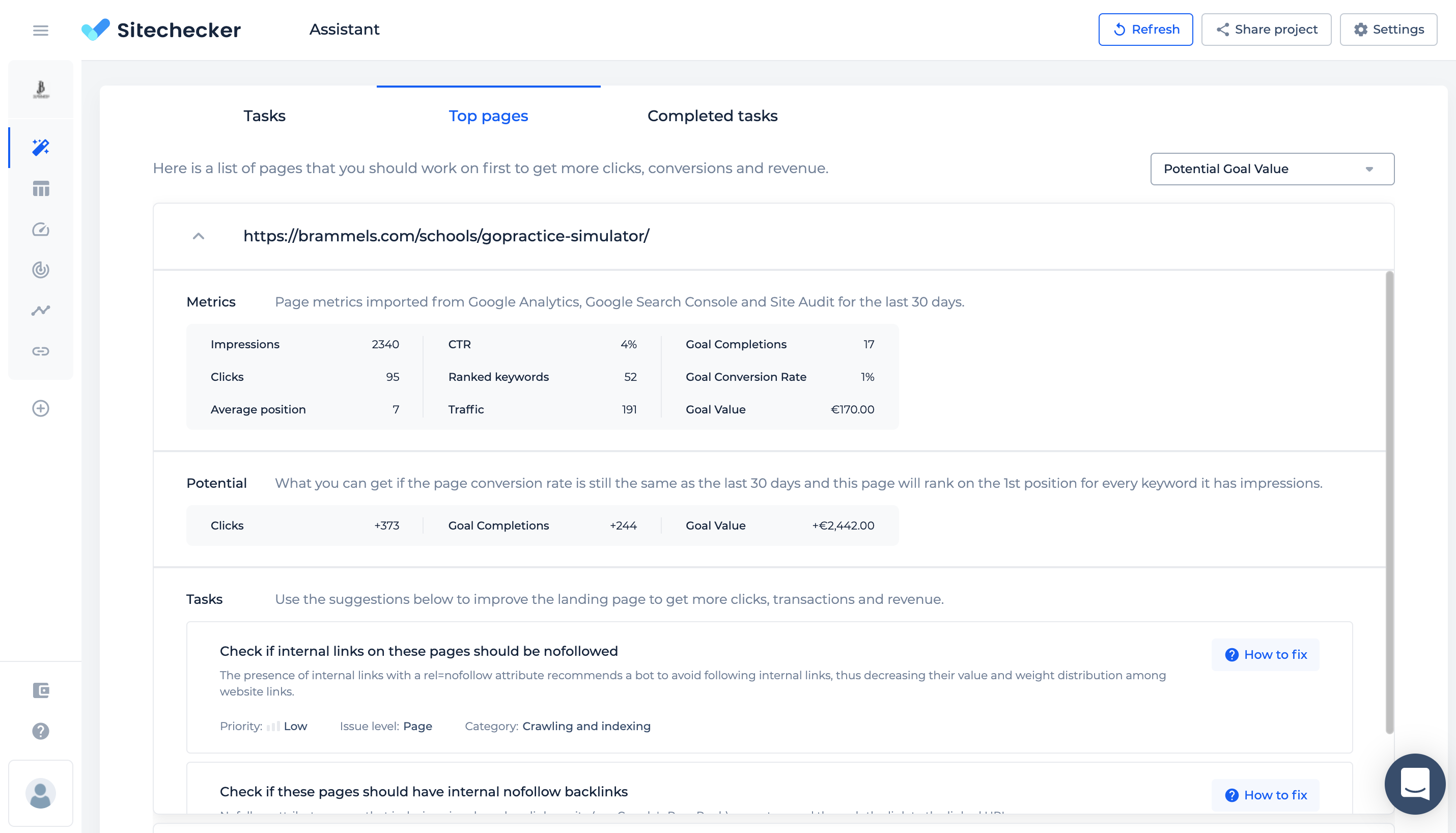

В любом из случаев вам нужно выгрузить данные накопленные за прошлый период в Google Analytics и Google Search Console и построить прогноз.

Это можно сделать:

- руками в таблице, что занимает много времени;

- используя мои шаблоны в Google Data Studio (это потребует от вас определенных навыков);

- использовать отчет Top pages в Sitechecker Assistant.

Что дальше

Это не исчерпывающий список шагов SEO аудита, но эти пункты будут ценны для любого сайта. Кроме универсальных решений, есть еще пункты, которые зависят от вашей CMS, типа бизнеса, размера сайта и так далее.

В WordPress сайтах нужно отдельно внимание уделять безопасности и скорости плагинов.

В локальных бизнесах нужно уделять внимание оптимизации Google My Business и Google Maps.

Для больших сайтов нужно обращать внимание на краулинговый бюджет Google и искать пути его оптимизации.

Для мультиязычных сайтов нужно проверить правильную настройку hreflang тегов.

Выделите такие параметры и поищите узкоспециализировании рекомендации по оптимизации такого типа сайтов.